Канули в Лету времена, когда компания Google расценивалась всего лишь как возмутитель спокойствия, ворвавшийся в размеренный мир сетевых ищеек. Вчерашний стартап прочно вошел в обойму влиятельнейших компаний мира IT, а многие из обитателей софтверного Олимпа почитают за счастье пожать руку недавним «выскочкам». Как это сделал глава Sun Скотт Макнили, скрепивший многочисленными рукопожатиями договор о сотрудничестве с CEO Google Эриком Шмидтом.

Канули в Лету времена, когда компания Google расценивалась всего лишь как возмутитель спокойствия, ворвавшийся в размеренный мир сетевых ищеек. Вчерашний стартап прочно вошел в обойму влиятельнейших компаний мира IT, а многие из обитателей софтверного Олимпа почитают за счастье пожать руку недавним «выскочкам». Как это сделал глава Sun Скотт Макнили, скрепивший многочисленными рукопожатиями договор о сотрудничестве с CEO Google Эриком Шмидтом. «Апорт», «лежать», «фас»… Увы, пригоршня коротких команд – это все, чем ограничиваются познания в лингвистике большинства наших четвероногих друзей, так что «за жизнь» с барбосом не поговоришь. То ли дело его умнеющий год от года электронный собрат: компания Sony представила новую породу робота-пса Aibo ERS-7M3, чей английский вокабулярий составляет тысячу слов (правда, понимает робот лишь одну десятую из того, что может говорить сам).

«Апорт», «лежать», «фас»… Увы, пригоршня коротких команд – это все, чем ограничиваются познания в лингвистике большинства наших четвероногих друзей, так что «за жизнь» с барбосом не поговоришь. То ли дело его умнеющий год от года электронный собрат: компания Sony представила новую породу робота-пса Aibo ERS-7M3, чей английский вокабулярий составляет тысячу слов (правда, понимает робот лишь одну десятую из того, что может говорить сам). Samsung наконец раскрыла подробности совместного проекта с датской фирмой Bang & Olufsen, анонсировав мобильный телефон Serene. Этот аппарат во многом повторяет концепцию Nokia Vertu, демонстрируя роскошный экстерьер и урезанные функциональные возможности.

Samsung наконец раскрыла подробности совместного проекта с датской фирмой Bang & Olufsen, анонсировав мобильный телефон Serene. Этот аппарат во многом повторяет концепцию Nokia Vertu, демонстрируя роскошный экстерьер и урезанные функциональные возможности. За свою разработку Накисчи получил 5 тысяч евро и оплаченную поездку в Хельсинки для встречи с дизайнерами Nokia. Конечно, мы вряд ли увидим такой телефон в действии раньше, чем лет через пять-десять. Для создания Nokia 888 потребуется целый набор инновационных технологий: топливные элементы питания, гибкий OLED-дисплей и электронные схемы (подобный модуль памяти TFT-SRAM в конце сентября представила Seiko Epson [на фото вверху] – все электронные цепи размещены на гибкой пластиковой подложке, правда пока емкость маловата – всего 16 кбит). – Т.Б.

За свою разработку Накисчи получил 5 тысяч евро и оплаченную поездку в Хельсинки для встречи с дизайнерами Nokia. Конечно, мы вряд ли увидим такой телефон в действии раньше, чем лет через пять-десять. Для создания Nokia 888 потребуется целый набор инновационных технологий: топливные элементы питания, гибкий OLED-дисплей и электронные схемы (подобный модуль памяти TFT-SRAM в конце сентября представила Seiko Epson [на фото вверху] – все электронные цепи размещены на гибкой пластиковой подложке, правда пока емкость маловата – всего 16 кбит). – Т.Б. Sarnoff, одна из ведущих корпораций американского военно-промышленного комплекса, объявила о создании «первой в мире системы опознания движущихся людей по радужной оболочке глаза». Учитывая значительно возросший спрос на системы быстрого биометрического опознания, конструкторы Sarnoff предложили рынку свою разработку Iris on the Move, внешне похожую на ворота металлоискателей, устанавливающиеся в аэропортах и всякого рода контрольно-пропускных пунктах. Новая система способна опознавать порядка двадцати человек в минуту по мере их прохождения через чувствительную раму. Повышение аккуратности и быстродействия аппаратуры достигнуто за счет применения нового алгоритма, эффективно отделяющего образ глаза от снимка остального лица, а также благодаря новой камере высокого разрешения и «сверхъярким» инфракрасным светодиодам, освещающим физиономию опознаваемого человека.

Sarnoff, одна из ведущих корпораций американского военно-промышленного комплекса, объявила о создании «первой в мире системы опознания движущихся людей по радужной оболочке глаза». Учитывая значительно возросший спрос на системы быстрого биометрического опознания, конструкторы Sarnoff предложили рынку свою разработку Iris on the Move, внешне похожую на ворота металлоискателей, устанавливающиеся в аэропортах и всякого рода контрольно-пропускных пунктах. Новая система способна опознавать порядка двадцати человек в минуту по мере их прохождения через чувствительную раму. Повышение аккуратности и быстродействия аппаратуры достигнуто за счет применения нового алгоритма, эффективно отделяющего образ глаза от снимка остального лица, а также благодаря новой камере высокого разрешения и «сверхъярким» инфракрасным светодиодам, освещающим физиономию опознаваемого человека. Нешуточный скандал разразился вокруг легендарной компании id Software, разработчика Doom и Quake. Ее бывший главный дизайнер и член совета директоров Адриан Кармак (Adrian Carmack; вопреки слухам, лишь однофамилец легендарного технического директора компании Джона Кармака) подал в суд на акционеров id. Кармак ушел оттуда в начале этого года, и ранее считалось, что уволился он добровольно. Теперь же он говорит, что к увольнению его вынудили, дабы лишить причитающейся доли в компании.

Нешуточный скандал разразился вокруг легендарной компании id Software, разработчика Doom и Quake. Ее бывший главный дизайнер и член совета директоров Адриан Кармак (Adrian Carmack; вопреки слухам, лишь однофамилец легендарного технического директора компании Джона Кармака) подал в суд на акционеров id. Кармак ушел оттуда в начале этого года, и ранее считалось, что уволился он добровольно. Теперь же он говорит, что к увольнению его вынудили, дабы лишить причитающейся доли в компании. Задуматься о туманных перспективах онлайнового обогащения Алекса заставила необходимость платить за учебу, и к чести своей, студент подошел к сей проблеме профессионально. Первый же день занятий будущий экономист отметил тем, что засел в дальнем углу университетского холла с ноутбуком и «мобилой» и создал сайт Milliondollarhomepage.com, призванный в будущем его озолотить. Подобно достопамятному Лене Голубкову, Алекс решил стать «не халявщиком, но партнером»: вместо размещения рядовой мольбы о помощи, он предпочел… продавать заглавную страницу по кусочкам всем желающим. Студент нарезал ее на квадратики размером 10x10 пикселов, которые предложил как рекламную площадь по курсу доллар за пиксел.

Задуматься о туманных перспективах онлайнового обогащения Алекса заставила необходимость платить за учебу, и к чести своей, студент подошел к сей проблеме профессионально. Первый же день занятий будущий экономист отметил тем, что засел в дальнем углу университетского холла с ноутбуком и «мобилой» и создал сайт Milliondollarhomepage.com, призванный в будущем его озолотить. Подобно достопамятному Лене Голубкову, Алекс решил стать «не халявщиком, но партнером»: вместо размещения рядовой мольбы о помощи, он предпочел… продавать заглавную страницу по кусочкам всем желающим. Студент нарезал ее на квадратики размером 10x10 пикселов, которые предложил как рекламную площадь по курсу доллар за пиксел. Современная геополитическая картина в значительной мере сложилась вследствие того, что человечество обладает оружием, которое даже сверхдержаве не дает чувствовать себя в безопасности. Ядерная дубинка не позволила войти в клинч не только США и СССР, но, например, Индии и Пакистану. Стремление овладеть супероружием или не допустить его распространения в значительной мере определяет современную политику. Когда начался подобный процесс и к чему он идет?

Современная геополитическая картина в значительной мере сложилась вследствие того, что человечество обладает оружием, которое даже сверхдержаве не дает чувствовать себя в безопасности. Ядерная дубинка не позволила войти в клинч не только США и СССР, но, например, Индии и Пакистану. Стремление овладеть супероружием или не допустить его распространения в значительной мере определяет современную политику. Когда начался подобный процесс и к чему он идет? Очередное ежегодное состязание автомобилей, питаемых энергией Солнца, в третий раз закончилось победой голландской команды. Машина Nuna 3 преодолела австралийскую трассу длиной три тысячи километров за 29 часов 11 минут, почти на два часа улучшив свое прошлогоднее достижение. – Т.Б.

Очередное ежегодное состязание автомобилей, питаемых энергией Солнца, в третий раз закончилось победой голландской команды. Машина Nuna 3 преодолела австралийскую трассу длиной три тысячи километров за 29 часов 11 минут, почти на два часа улучшив свое прошлогоднее достижение. – Т.Б. МИД Тайваня обратился к Google с просьбой внести коррективы в онлайновые сервисы Google Maps. На виртуальной карте остров обозначен как «провинция Китая». Официальный же Тайвань настаивает на использовании термина «независимое государство». На сегодняшний день Тайвань признан независимым лишь 26 странами. Сепаратизм не приветствуется континентальным Китаем – Поднебесная уже неоднократно обещала ввести на остров войска. – Т.Б.

МИД Тайваня обратился к Google с просьбой внести коррективы в онлайновые сервисы Google Maps. На виртуальной карте остров обозначен как «провинция Китая». Официальный же Тайвань настаивает на использовании термина «независимое государство». На сегодняшний день Тайвань признан независимым лишь 26 странами. Сепаратизм не приветствуется континентальным Китаем – Поднебесная уже неоднократно обещала ввести на остров войска. – Т.Б. Мысль о том, что самое главное для ребенка (после того, как он накормлен-обут-одет) – это доступ к образованию благодаря собственному компьютеру, пришла к Негропонте после посещения деревень в джунглях Камбоджи.

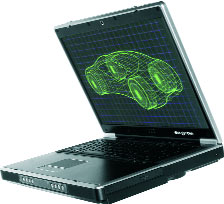

Мысль о том, что самое главное для ребенка (после того, как он накормлен-обут-одет) – это доступ к образованию благодаря собственному компьютеру, пришла к Негропонте после посещения деревень в джунглях Камбоджи. Что же представляет собой созданный в Media Labs лэптоп и почему он так дешев? Конструкцию компьютера вполне можно назвать спартанской. Он будет иметь усиленный, скорее всего резиновый, герметично закрывающийся корпус. Следует отметить ЖК-дисплей, на который приходится больше трети стоимости устройства и который может выступать в двух ипостасях: как цветной TFT-экран для «обычного» режима работы и как экономный черно-белый экран для энергосберегающих режимов вроде «электронной книги». Жесткий диск не предусмотрен, в качестве ЗУ выступает флэш-память объемом 1—2 Гбайт, в целом же аппарат по своей концепции является «тонким клиентом», ориентированным на хранение данных в Сети. Коммуникационные возможности – четыре порта USB и беспроводной адаптер Wi-Fi. Операционная система, естественно, Linux, и в сильно облегченном варианте. Одна из фишек – вытяжная ручка собственного электрогенератора, вращая которую, можно подпитывать компьютер энергией из расчета одна минута подкачки на десять минут работы.

Что же представляет собой созданный в Media Labs лэптоп и почему он так дешев? Конструкцию компьютера вполне можно назвать спартанской. Он будет иметь усиленный, скорее всего резиновый, герметично закрывающийся корпус. Следует отметить ЖК-дисплей, на который приходится больше трети стоимости устройства и который может выступать в двух ипостасях: как цветной TFT-экран для «обычного» режима работы и как экономный черно-белый экран для энергосберегающих режимов вроде «электронной книги». Жесткий диск не предусмотрен, в качестве ЗУ выступает флэш-память объемом 1—2 Гбайт, в целом же аппарат по своей концепции является «тонким клиентом», ориентированным на хранение данных в Сети. Коммуникационные возможности – четыре порта USB и беспроводной адаптер Wi-Fi. Операционная система, естественно, Linux, и в сильно облегченном варианте. Одна из фишек – вытяжная ручка собственного электрогенератора, вращая которую, можно подпитывать компьютер энергией из расчета одна минута подкачки на десять минут работы. Восьмидесятилетний патриарх Рой Глаубер [1] отмечен за свои достижения еще шестидесятых годов прошлого века, когда ему удалось применить квантование электромагнитного поля для корректного описания процессов поглощения и испускания света. Эти работы дали теоретический базис новым оптическим наблюдениям и легли в основу квантовой оптики.

Восьмидесятилетний патриарх Рой Глаубер [1] отмечен за свои достижения еще шестидесятых годов прошлого века, когда ему удалось применить квантование электромагнитного поля для корректного описания процессов поглощения и испускания света. Эти работы дали теоретический базис новым оптическим наблюдениям и легли в основу квантовой оптики. Проблемы были решены вместе с созданием квантовой оптики, объяснившей статистические закономерности оптических измерений, которые носят квантовую природу. В числе прочего законы квантовой оптики устанавливают предел точности экспериментов, ограниченный принципиально непреодолимыми квантовыми шумами электромагнитного поля.

Проблемы были решены вместе с созданием квантовой оптики, объяснившей статистические закономерности оптических измерений, которые носят квантовую природу. В числе прочего законы квантовой оптики устанавливают предел точности экспериментов, ограниченный принципиально непреодолимыми квантовыми шумами электромагнитного поля. Выдающееся достижение Холла и Хенша последних лет – метод гребенки оптических частот – позволил «привязать» оптические частоты излучения лазеров порядка 1015 Гц к цезиевому эталону времени, работающему с частотой 9,2 ГГц (разница в пять порядков по частоте создавала огромные технические проблемы). Линейчатый спектр лазерных импульсов похож на частую и острую гребенку, которая покрывает весь видимый спектр (что и дало название методу). Хитрый трюк позволяет получить из гребенки биения радиочастоты и сравнить их с цезиевым эталоном. Благодаря этому, точно вычисляется частота каждого из ее зубьев. Этот элегантный метод уже позволяет выпускать коммерчески доступные эталонные излучатели, умещающиеся на лабораторном столе. Дальнейшее развитие метода и переход к аттосекундным импульсам обещает в ближайшие годы повышение точности еще на три порядка и достижение рентгеновского диапазона энергий.

Выдающееся достижение Холла и Хенша последних лет – метод гребенки оптических частот – позволил «привязать» оптические частоты излучения лазеров порядка 1015 Гц к цезиевому эталону времени, работающему с частотой 9,2 ГГц (разница в пять порядков по частоте создавала огромные технические проблемы). Линейчатый спектр лазерных импульсов похож на частую и острую гребенку, которая покрывает весь видимый спектр (что и дало название методу). Хитрый трюк позволяет получить из гребенки биения радиочастоты и сравнить их с цезиевым эталоном. Благодаря этому, точно вычисляется частота каждого из ее зубьев. Этот элегантный метод уже позволяет выпускать коммерчески доступные эталонные излучатели, умещающиеся на лабораторном столе. Дальнейшее развитие метода и переход к аттосекундным импульсам обещает в ближайшие годы повышение точности еще на три порядка и достижение рентгеновского диапазона энергий. Премия по химии разделена между французским ученым Ивом Шовеном (Yves Chauvin) и американцами Робертом Груббсом (Robert Grubbs) и Ричардом Шроком (Richard Schrock) – «за развитие метода метатезиса в органическом синтезе».

Премия по химии разделена между французским ученым Ивом Шовеном (Yves Chauvin) и американцами Робертом Груббсом (Robert Grubbs) и Ричардом Шроком (Richard Schrock) – «за развитие метода метатезиса в органическом синтезе». Органические вещества, составляющие основу всего живого, так разнообразны благодаря уникальным свойствам атомов углерода, которые способны образовывать длинные цепочки и кольца с одинарными и двойными связями, а также соединяться с атомами других элементов. В обменных реакциях две органические молекулы разделяются на части путем разрыва двойной углеродной связи и обмениваются своими частями, образуя новые соединения. Такой обмен становится возможным благодаря помощи молекул-катализаторов, играющих роль посредников.

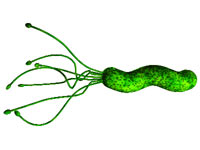

Органические вещества, составляющие основу всего живого, так разнообразны благодаря уникальным свойствам атомов углерода, которые способны образовывать длинные цепочки и кольца с одинарными и двойными связями, а также соединяться с атомами других элементов. В обменных реакциях две органические молекулы разделяются на части путем разрыва двойной углеродной связи и обмениваются своими частями, образуя новые соединения. Такой обмен становится возможным благодаря помощи молекул-катализаторов, играющих роль посредников. Премию по физиологии и медицине получили австралийцы Барри Маршалл (Barry Marshall) и Робин Уоррен (Robin Warren) за открытие роли микроорганизма Helicobacter pylori [7] в развитии гастрита, язвы желудка и двенадцатиперстной кишки. Помимо распространенности заболевания, поражающего, по последним данным, до десяти и более процентов взрослого населения в развитых странах, впечатляет неожиданность открытия.

Премию по физиологии и медицине получили австралийцы Барри Маршалл (Barry Marshall) и Робин Уоррен (Robin Warren) за открытие роли микроорганизма Helicobacter pylori [7] в развитии гастрита, язвы желудка и двенадцатиперстной кишки. Помимо распространенности заболевания, поражающего, по последним данным, до десяти и более процентов взрослого населения в развитых странах, впечатляет неожиданность открытия. А что же стресс и грубая пища – не имеют отношения к язве? Еще как имеют. Однако есть разница между причинным (этиологическим) фактором, условиями его реализации и механизмами развития нарушений (патогенезом). Установка или неустановка файрвола может иметь решающее значение как условие для заражения (или незаражения) компьютерным вирусом. Действия вируса в компьютере, его своевременное (или несвоевременное) обнаружение и уничтожение – факторы патогенеза. Но этиологический-то фактор, вокруг которого все закручивается, – сам вирус.

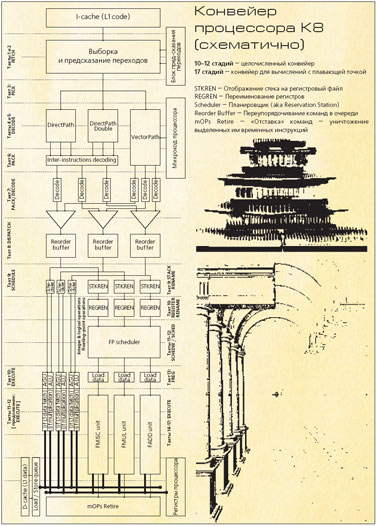

А что же стресс и грубая пища – не имеют отношения к язве? Еще как имеют. Однако есть разница между причинным (этиологическим) фактором, условиями его реализации и механизмами развития нарушений (патогенезом). Установка или неустановка файрвола может иметь решающее значение как условие для заражения (или незаражения) компьютерным вирусом. Действия вируса в компьютере, его своевременное (или несвоевременное) обнаружение и уничтожение – факторы патогенеза. Но этиологический-то фактор, вокруг которого все закручивается, – сам вирус. Исполнение инструкций на конвейере K8, как и положено, начинается с блока выборки инструкций. За один такт блок выбирает из кэша 16 байт данных и выделяет из них от одной до трех инструкций x86 – сколько в выбранных данных поместилось[Поскольку средняя длина инструкции x86 составляет 5—6 байт, то, как правило, блоку удается выбрать три инструкции за такт]. Чтобы облегчить процесс декодирования, инструкции, хранящиеся в кэшах L1, тегированы – в линейках кэша сохраняется информация о том, как внутри этой линейки распределены инструкции x86. Попутно с помощью блока предсказания переходов в этом же такте определяется адрес блока, с которого начнется выборка в следующем такте. Тегирование производится при выборке данных из кэша L2 в кэш L1 I-cache; при вытеснении данных из L1 в L2 теги сохраняются.

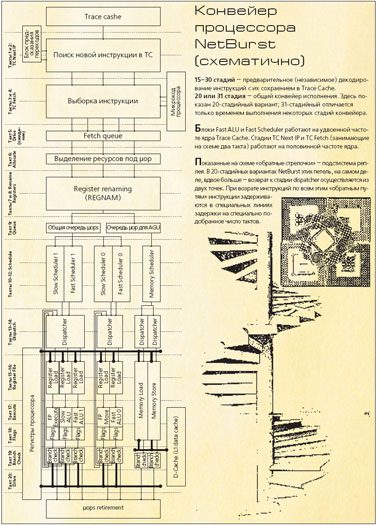

Исполнение инструкций на конвейере K8, как и положено, начинается с блока выборки инструкций. За один такт блок выбирает из кэша 16 байт данных и выделяет из них от одной до трех инструкций x86 – сколько в выбранных данных поместилось[Поскольку средняя длина инструкции x86 составляет 5—6 байт, то, как правило, блоку удается выбрать три инструкции за такт]. Чтобы облегчить процесс декодирования, инструкции, хранящиеся в кэшах L1, тегированы – в линейках кэша сохраняется информация о том, как внутри этой линейки распределены инструкции x86. Попутно с помощью блока предсказания переходов в этом же такте определяется адрес блока, с которого начнется выборка в следующем такте. Тегирование производится при выборке данных из кэша L2 в кэш L1 I-cache; при вытеснении данных из L1 в L2 теги сохраняются. NetBurst тщательно оптимизировалась для работы на высоких частотах, и назвать эту архитектуру классической можно только с большой натяжкой. Для начала упомянем хотя бы тот же Trace Cache (TC), заменяющий в NetBurst классический Гарвардский I-cache (L1 code). Идея состоит в том, что в NetBurst декодер вынесен за пределы собственно конвейера – процессор конвертирует x86-инструкции в свое внутреннее представление не на лету, как AMD K8, а заблаговременно, еще на стадии копирования кода в кэш-память первого уровня. Устроено это все так своеобразно (например, в процессе декодирования декодер убирает безусловные переходы, занимается предсказанием условных переходов и может едва ли не «разворачивать» циклы!), что внутреннему устройству Trace Cache и декодеру инструкций для него вообще можно посвятить отдельную статью (чего мы делать сейчас не будем; скажем только, что декодер для TC работает очень медленно). Точная длина соответствующего участка конвейера неизвестна, но составляет, по разным оценкам, от 10—15 до 30 тактов – то есть этот «скрытый» участок конвейера имеет длину едва ли не большую, чем «видимый». Таким образом, введение TC позволяет практически вдвое уменьшить эффективную длину конвейера (страшно даже представить NetBurst без Trace Cache)[С K8, кстати, та же самая история – декодированием и подготовкой инструкций занята примерно половина конвейера. Есть предположения, что в следующем поколении процессоров AMD – архитектуре K9 – появится и Trace Cache. Скажем, в K8 подобное нововведение уменьшило бы видимую длину конвейера до 6—7 стадий в целочисленных вычислениях и до 12 стадий в вычислениях с плавающей точкой!]! Емкость TC для всех NetBurst составляет 12 тысяч микроопераций; в терминах классического x86 это соответствует примерно 8—16 Кбайт кэша L1-data; причем работает TC и обслуживающая его логика на половинной частоте ядра и наполняется декодером с темпом не более одной новой инструкции за такт. Поэтому если процессор некстати вылетит на незакэшированный участок кода (а кэш маленький, и подобная ситуация вполне возможна), то от теоретически возможных четырех инструкций за такт в лучшем случае останется лишь одна. Подобные «резкие потери темпа» вообще свойственны архитектуре NetBurst; к счастью, такие ситуации возникают редко.

NetBurst тщательно оптимизировалась для работы на высоких частотах, и назвать эту архитектуру классической можно только с большой натяжкой. Для начала упомянем хотя бы тот же Trace Cache (TC), заменяющий в NetBurst классический Гарвардский I-cache (L1 code). Идея состоит в том, что в NetBurst декодер вынесен за пределы собственно конвейера – процессор конвертирует x86-инструкции в свое внутреннее представление не на лету, как AMD K8, а заблаговременно, еще на стадии копирования кода в кэш-память первого уровня. Устроено это все так своеобразно (например, в процессе декодирования декодер убирает безусловные переходы, занимается предсказанием условных переходов и может едва ли не «разворачивать» циклы!), что внутреннему устройству Trace Cache и декодеру инструкций для него вообще можно посвятить отдельную статью (чего мы делать сейчас не будем; скажем только, что декодер для TC работает очень медленно). Точная длина соответствующего участка конвейера неизвестна, но составляет, по разным оценкам, от 10—15 до 30 тактов – то есть этот «скрытый» участок конвейера имеет длину едва ли не большую, чем «видимый». Таким образом, введение TC позволяет практически вдвое уменьшить эффективную длину конвейера (страшно даже представить NetBurst без Trace Cache)[С K8, кстати, та же самая история – декодированием и подготовкой инструкций занята примерно половина конвейера. Есть предположения, что в следующем поколении процессоров AMD – архитектуре K9 – появится и Trace Cache. Скажем, в K8 подобное нововведение уменьшило бы видимую длину конвейера до 6—7 стадий в целочисленных вычислениях и до 12 стадий в вычислениях с плавающей точкой!]! Емкость TC для всех NetBurst составляет 12 тысяч микроопераций; в терминах классического x86 это соответствует примерно 8—16 Кбайт кэша L1-data; причем работает TC и обслуживающая его логика на половинной частоте ядра и наполняется декодером с темпом не более одной новой инструкции за такт. Поэтому если процессор некстати вылетит на незакэшированный участок кода (а кэш маленький, и подобная ситуация вполне возможна), то от теоретически возможных четырех инструкций за такт в лучшем случае останется лишь одна. Подобные «резкие потери темпа» вообще свойственны архитектуре NetBurst; к счастью, такие ситуации возникают редко. 3/4-дюймовый 8-Мп ПЗС-сенсор

3/4-дюймовый 8-Мп ПЗС-сенсор диагональ 20,1 дюйма

диагональ 20,1 дюйма цветной 1,5-дюймовый ЖК-экран

цветной 1,5-дюймовый ЖК-экран 1/1,7-дюймовый 6,3-Мп ПЗС-сенсор (Super CCD XR с восьмиугольными фотодиодами)

1/1,7-дюймовый 6,3-Мп ПЗС-сенсор (Super CCD XR с восьмиугольными фотодиодами) 1/2,5-дюймовый 5,1-Мп ПЗС-сенсор

1/2,5-дюймовый 5,1-Мп ПЗС-сенсор термоструйная технология печати

термоструйная технология печати цветная тандемная лазерная печать

цветная тандемная лазерная печать процессор Pentium M 760 (вариант 780)

процессор Pentium M 760 (вариант 780) 300-МГц процессор Samsung SC32442

300-МГц процессор Samsung SC32442 принтер, сканер, копир для фотографий

принтер, сканер, копир для фотографий процессор AMD Athlon 64 X2 3800+ (либо одноядерный 2,6-ГГц Athlon FX-57)

процессор AMD Athlon 64 X2 3800+ (либо одноядерный 2,6-ГГц Athlon FX-57) платформа VIA-EPIA

платформа VIA-EPIA 512 Мбайт флэш-памяти

512 Мбайт флэш-памяти разрешение принтера до 9600x2400 dpi

разрешение принтера до 9600x2400 dpi Однако по тем ли, по иным ли причинам игровые шлемы в народ широко не пошли и как-то… заглохли. Промышленные же «носильники», не исключено, процветают и до сих пор, – но в своей узкой нише, в которую читатели «Компьютерры» протискиваются лишь изредка, да и то не все. Поэтому, зайдя в ближайший к дому магазинчик сети LEFUTUR[Будущее время (фр.)], специализирующийся на продаже задорого разных прикольных вещиц, идеально подходящих для подарков, на DVD-очки я обратил внимание особое. Они показались мне – в контексте – игрушкой достаточно свежей или, во всяком случае, – достаточно хорошо забытой.

Однако по тем ли, по иным ли причинам игровые шлемы в народ широко не пошли и как-то… заглохли. Промышленные же «носильники», не исключено, процветают и до сих пор, – но в своей узкой нише, в которую читатели «Компьютерры» протискиваются лишь изредка, да и то не все. Поэтому, зайдя в ближайший к дому магазинчик сети LEFUTUR[Будущее время (фр.)], специализирующийся на продаже задорого разных прикольных вещиц, идеально подходящих для подарков, на DVD-очки я обратил внимание особое. Они показались мне – в контексте – игрушкой достаточно свежей или, во всяком случае, – достаточно хорошо забытой. Очки распаковали, к плейеру подключили, я вздел их на нос и обнаружил сетчатую черно-белую картинку. «Эге, – сказали мы с Петром Ивановичем… Разбираться-то, похоже, все-таки придется…» Но особо разбираться так и не понадобилось: на последней страничке тонюсенького руководства было ясно указано, что Video Input Signal – NTSC, 1Vp-p/75J2. То есть, как у них говорилось в пятидесятые годы прошлого века и раньше, – «Только для белых!».

Очки распаковали, к плейеру подключили, я вздел их на нос и обнаружил сетчатую черно-белую картинку. «Эге, – сказали мы с Петром Ивановичем… Разбираться-то, похоже, все-таки придется…» Но особо разбираться так и не понадобилось: на последней страничке тонюсенького руководства было ясно указано, что Video Input Signal – NTSC, 1Vp-p/75J2. То есть, как у них говорилось в пятидесятые годы прошлого века и раньше, – «Только для белых!». «Скромная» эта скорость – 5,3 Kbps – вовсе не исключение из правил, а норма, потому как телефонная лапша в городе Кишиневе давно цифровая, а расценки – 12 долларов в месяц за полный анлим – позволяют качать денно и нощно до посинения. К слову, 12 долларов многим местным сетевым маньякам кажутся непристойно завышенными, поскольку, с одной стороны, в течение трех дней можно установить ADSL по ценам, аналогичным московскому «СТРИМу», а с другой – существуют варианты вообще чуть ли не дармового дайлапа: покупаете за 5 долларов скрэтч-карту, к примеру, провайдера Arax и далее пользуетесь ею до скончания веков, потому как по субботам и воскресеньям, а также по будням с 19:00 до 9:00 соединение бесплатно!

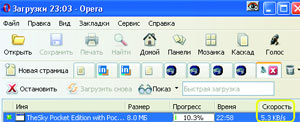

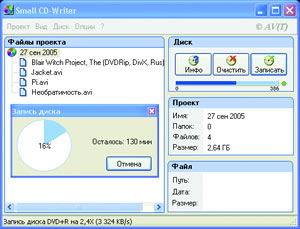

«Скромная» эта скорость – 5,3 Kbps – вовсе не исключение из правил, а норма, потому как телефонная лапша в городе Кишиневе давно цифровая, а расценки – 12 долларов в месяц за полный анлим – позволяют качать денно и нощно до посинения. К слову, 12 долларов многим местным сетевым маньякам кажутся непристойно завышенными, поскольку, с одной стороны, в течение трех дней можно установить ADSL по ценам, аналогичным московскому «СТРИМу», а с другой – существуют варианты вообще чуть ли не дармового дайлапа: покупаете за 5 долларов скрэтч-карту, к примеру, провайдера Arax и далее пользуетесь ею до скончания веков, потому как по субботам и воскресеньям, а также по будням с 19:00 до 9:00 соединение бесплатно! Small CD-Writer (рис. 2) – это такая крохотуля размером 393 килобайта и… больше ничего! Ни тебе дюжины dll’ок, ни конфигурационных файлов, ни вообще какой бы то ни было инсталляции: копируешь единственный экзешник в любую директорию и получаешь надежный до протирки глаз «резак» компакт-дисков. Причем не какую-то там жалкую циркумцизию Nero, а полноценный прожигатель, умеющий создавать многосессионные и загрузочные диски, записывать ISО-образы, просматривать все сессии диска и извлекать из них файлы, сохранять проекты в виде ISO-образов. Крохотуля автоматически определяет тип пишущего привода, скорость записи и далее работает по накатанной, не донимая пользователя дурацкими дополнительными настройками, главная особенность которых – по личному ба-а-альшому опыту: стоит только изменить хоть одну маципурку, выставленную по умолчанию, как тут же получаешь горку испоганенных болванок.

Small CD-Writer (рис. 2) – это такая крохотуля размером 393 килобайта и… больше ничего! Ни тебе дюжины dll’ок, ни конфигурационных файлов, ни вообще какой бы то ни было инсталляции: копируешь единственный экзешник в любую директорию и получаешь надежный до протирки глаз «резак» компакт-дисков. Причем не какую-то там жалкую циркумцизию Nero, а полноценный прожигатель, умеющий создавать многосессионные и загрузочные диски, записывать ISО-образы, просматривать все сессии диска и извлекать из них файлы, сохранять проекты в виде ISO-образов. Крохотуля автоматически определяет тип пишущего привода, скорость записи и далее работает по накатанной, не донимая пользователя дурацкими дополнительными настройками, главная особенность которых – по личному ба-а-альшому опыту: стоит только изменить хоть одну маципурку, выставленную по умолчанию, как тут же получаешь горку испоганенных болванок. Чудо сие искал долго и безрезультатно, пока – обалдеть можно! – не нашел его там же, где и Small CD-Writer! Называется сей миракль URL-Album (рис. 4).

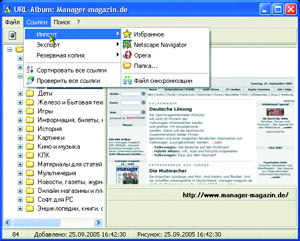

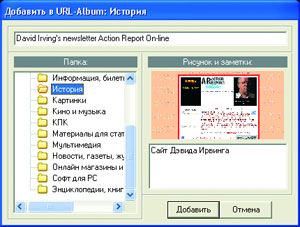

Чудо сие искал долго и безрезультатно, пока – обалдеть можно! – не нашел его там же, где и Small CD-Writer! Называется сей миракль URL-Album (рис. 4). Чем же так привлекательно хранение закладок в URL-Album? Главная причина очевидна: мы упорядочиваем пространство, по умолчанию тяготеющее к болезненной энтропии. Другое преимущество: закладки хранятся в предельно выразительной форме: в левой части окна – традиционное дерево категорий, в правой – скриншот веб-страницы и небольшое окошко для личных комментариев. Лично для меня наибольшей привлекательностью обладает мобильность базы данных URL-Album. Сколько раз, переустанавливая систему, мы оплакивали навсегда утерянную информацию из-за того, что забывали выковыривать из разрозненных поддиректорий файлы, в которых враждующие между собой браузеры хранят закладки? Теперь это в прошлом: URL-Album сохраняет резервные копии базы данных автоматически по графику либо в ручном режиме, позволяя с легкостью переносить favorites с компьютера на компьютер. Браво Анатолий!

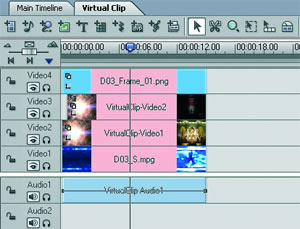

Чем же так привлекательно хранение закладок в URL-Album? Главная причина очевидна: мы упорядочиваем пространство, по умолчанию тяготеющее к болезненной энтропии. Другое преимущество: закладки хранятся в предельно выразительной форме: в левой части окна – традиционное дерево категорий, в правой – скриншот веб-страницы и небольшое окошко для личных комментариев. Лично для меня наибольшей привлекательностью обладает мобильность базы данных URL-Album. Сколько раз, переустанавливая систему, мы оплакивали навсегда утерянную информацию из-за того, что забывали выковыривать из разрозненных поддиректорий файлы, в которых враждующие между собой браузеры хранят закладки? Теперь это в прошлом: URL-Album сохраняет резервные копии базы данных автоматически по графику либо в ручном режиме, позволяя с легкостью переносить favorites с компьютера на компьютер. Браво Анатолий! Однако в 2003—04 годах MediaStudio Pro стал сдавать позиции редактору Sony Vegas Video, который, в частности, имел прекрасные возможности работы со звуком. Компания Ulead Systems, разумеется, все понимала и, надеясь снова оторваться от конкурентов, с конца прошлого года форсировала разработку принципиально новой, 8-й версии программы (текущая – 7.3). В ней меняется почти все. Из важнейших новшеств – так называемый однодорожечный монтаж, в котором нет никаких выделенных дорожек, все дорожки равнозначны, переходы и спецэффекты могут быть вставлены где угодно.

Однако в 2003—04 годах MediaStudio Pro стал сдавать позиции редактору Sony Vegas Video, который, в частности, имел прекрасные возможности работы со звуком. Компания Ulead Systems, разумеется, все понимала и, надеясь снова оторваться от конкурентов, с конца прошлого года форсировала разработку принципиально новой, 8-й версии программы (текущая – 7.3). В ней меняется почти все. Из важнейших новшеств – так называемый однодорожечный монтаж, в котором нет никаких выделенных дорожек, все дорожки равнозначны, переходы и спецэффекты могут быть вставлены где угодно. Идея однодорожечного монтажа, конечно же, придумана не Ulead и всегда была популярна среди профи. Многие другие изменения в восьмой версии тоже давно использовались в профессиональных монтажных программах. Окончательно оценить новинку можно будет только после ее выхода в свет (она ожидается до конца нынешнего года).

Идея однодорожечного монтажа, конечно же, придумана не Ulead и всегда была популярна среди профи. Многие другие изменения в восьмой версии тоже давно использовались в профессиональных монтажных программах. Окончательно оценить новинку можно будет только после ее выхода в свет (она ожидается до конца нынешнего года). Резюме: MediaStudio Pro и Vegas Video удовлетворят потребности 90% любителей (в том числе и тех, кто не обделен вкусом и фантазией) и позволят без особых проблем реализовать практически любые замыслы. Но эти программы уже не «все в одном». Для создания DVD-Video дисков, например, придется воспользоваться другой программой – либо от производителя самого видеоредактора (для Ulead это DVD Movie Factory, входящая в комплект поставки, для Vegas – DVD Architect), либо какой-нибудь другой. Оба редактора умеют кодировать видеоматериал в MPEG-2 с не самым лучшим, но вполне приемлемым качеством.

Резюме: MediaStudio Pro и Vegas Video удовлетворят потребности 90% любителей (в том числе и тех, кто не обделен вкусом и фантазией) и позволят без особых проблем реализовать практически любые замыслы. Но эти программы уже не «все в одном». Для создания DVD-Video дисков, например, придется воспользоваться другой программой – либо от производителя самого видеоредактора (для Ulead это DVD Movie Factory, входящая в комплект поставки, для Vegas – DVD Architect), либо какой-нибудь другой. Оба редактора умеют кодировать видеоматериал в MPEG-2 с не самым лучшим, но вполне приемлемым качеством. DMF также умеет захватывать видео, и если вы не хотите тратиться на бытовой DVD-рекордер, программа вполне может его заменить. Просто подключаете камеру к компьютеру, сбрасываете на него видео и сразу же делаете DVD-Video-диск.

DMF также умеет захватывать видео, и если вы не хотите тратиться на бытовой DVD-рекордер, программа вполне может его заменить. Просто подключаете камеру к компьютеру, сбрасываете на него видео и сразу же делаете DVD-Video-диск. Sonic Scenarist Pro

Sonic Scenarist Pro Список все увеличивался и увеличивался. Но почему одно приложение мы отнесли к Вебу 1.0, а второе – к категории Веб 2.0? (Это важный вопрос, поскольку Веб 2.0 стал настолько популярным, что многие компании используют сегодня этот термин в своем маркетинге, зачастую даже не понимая, что он означает. С другой стороны, этот вопрос не так уж прост, потому что множество падких на красивые термины стартапов не имеют никакого отношения к Вебу 2.0, тогда как отдельные приложения, которые мы считаем Вебом 2.0, даже веб-приложениями не являются – например, Napster и BitTorrent.)

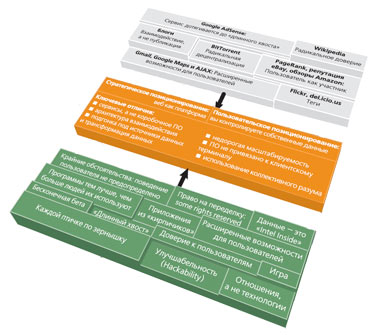

Список все увеличивался и увеличивался. Но почему одно приложение мы отнесли к Вебу 1.0, а второе – к категории Веб 2.0? (Это важный вопрос, поскольку Веб 2.0 стал настолько популярным, что многие компании используют сегодня этот термин в своем маркетинге, зачастую даже не понимая, что он означает. С другой стороны, этот вопрос не так уж прост, потому что множество падких на красивые термины стартапов не имеют никакого отношения к Вебу 2.0, тогда как отдельные приложения, которые мы считаем Вебом 2.0, даже веб-приложениями не являются – например, Napster и BitTorrent.) На рисунке показана карта Веба 2.0, созданная нами во время мозгового штурма на конференции FOO Camp. Ее нельзя назвать завершенной, но она иллюстрирует многие ключевые идеи Веба 2.0.

На рисунке показана карта Веба 2.0, созданная нами во время мозгового штурма на конференции FOO Camp. Ее нельзя назвать завершенной, но она иллюстрирует многие ключевые идеи Веба 2.0. Если ключевая часть Веба 2.0 – использование коллективного разума – превращает веб в некое подобие глобального мозга, то блогосфера – это его внутренний голос. Может, он и не связан с глубинными структурами мозга (подсознанием), но является аналогом мышления. Мощный всплеск блогосферы как отражения того, о чем люди думают и чему уделяют внимание, вызван следующим.

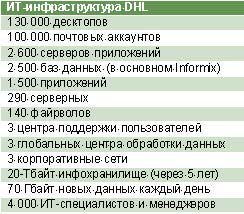

Если ключевая часть Веба 2.0 – использование коллективного разума – превращает веб в некое подобие глобального мозга, то блогосфера – это его внутренний голос. Может, он и не связан с глубинными структурами мозга (подсознанием), но является аналогом мышления. Мощный всплеск блогосферы как отражения того, о чем люди думают и чему уделяют внимание, вызван следующим. Сразу скажу, что до конца разобраться в этом вопросе мне так и не удалось. Значительная часть информации, касающейся структуры расходов DHL, закрыта. Но известно, например, что только на пражский центр в ближайшие пять лет будет потрачено 500 млн. евро (краткие технические характеристики центра сведены в таблицу 2). При этом создание центра в Чехии вызвано желанием оптимизировать работу ИТ-служб DHL (и, вероятно, сократить расходы на ИТ) – компания отказалась от концепции национальных ИТ-центров в пользу трех глобальных информационных мегаплощадок, которые и будут обрабатывать львиную долю информационного потока DHL (см. таблицу 3).

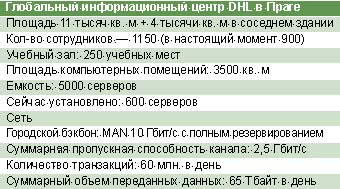

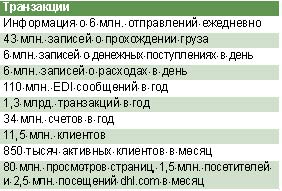

Сразу скажу, что до конца разобраться в этом вопросе мне так и не удалось. Значительная часть информации, касающейся структуры расходов DHL, закрыта. Но известно, например, что только на пражский центр в ближайшие пять лет будет потрачено 500 млн. евро (краткие технические характеристики центра сведены в таблицу 2). При этом создание центра в Чехии вызвано желанием оптимизировать работу ИТ-служб DHL (и, вероятно, сократить расходы на ИТ) – компания отказалась от концепции национальных ИТ-центров в пользу трех глобальных информационных мегаплощадок, которые и будут обрабатывать львиную долю информационного потока DHL (см. таблицу 3). Предполагается, что подобная консолидация (центр в Чехии возник в результате слияния швейцарского, французского, британского ИТ-центров и нескольких центров помельче) позволит сократить издержки, хотя оценить это сокращение трудно и данных об эффективности перехода к трем глобальным центрам, каждый из которых подстраховывает остальные, пока нет.

Предполагается, что подобная консолидация (центр в Чехии возник в результате слияния швейцарского, французского, британского ИТ-центров и нескольких центров помельче) позволит сократить издержки, хотя оценить это сокращение трудно и данных об эффективности перехода к трем глобальным центрам, каждый из которых подстраховывает остальные, пока нет. В идеальном мире три ИТ-центра DHL (Скоттсдэйл, США; Прага, Чехия; Сайберджайя, Малайзия) были бы равноценны, однако национальные и исторические особенности все-таки берут свое. Так, специалистам в Скоттсдэйле приходится работать с мэйнфреймами – в Европе старой инфраструктуры у DHL почти нет, поэтому и надобности в подобных специалистах тоже нет. Малайзийский центр примечателен тем, что именно в нем пишется значительная часть программного обеспечения DHL (собственно говоря, многие задачи, связанные с созданием приложением, DHL аутсорсит, но кое-что приходится писать самим, да и постановку задачи никто другой осуществить не в состоянии).

В идеальном мире три ИТ-центра DHL (Скоттсдэйл, США; Прага, Чехия; Сайберджайя, Малайзия) были бы равноценны, однако национальные и исторические особенности все-таки берут свое. Так, специалистам в Скоттсдэйле приходится работать с мэйнфреймами – в Европе старой инфраструктуры у DHL почти нет, поэтому и надобности в подобных специалистах тоже нет. Малайзийский центр примечателен тем, что именно в нем пишется значительная часть программного обеспечения DHL (собственно говоря, многие задачи, связанные с созданием приложением, DHL аутсорсит, но кое-что приходится писать самим, да и постановку задачи никто другой осуществить не в состоянии). Возвращаясь в Москву, я думал, почему у нас в России такого нет. Почему именно Чехия стала так популярна среди ИТ-компаний, которые не только открывают там новые офисы, но и переводят туда исправно работавшие центры из других стран. По соседству с DHL расположились Dell и Sony, по пути из Праги-1 в Чодов с трассы виден другой технопарк, в котором обустроилась Microsoft. Почему туда, а не к нам? Понятно, что Чехия удобнее расположена, если говорить о ведении бизнеса в Европе, но ведь у нас «такая база!», «такое образование!», «такие люди!». Спросите любого российского айтишника, и он расскажет, что американцы – идиоты, индийцы – совершенно не умеют писать код, а главное ИТ-достижение Чехии – штрих-код на бутылке «Старопрамен». Так почему же не к нам? Пусть не все, но хотя бы кто-то. Ведь мы тоже много говорим о технопарках и о том, как будет хорошо, если построить огромные здания из стекла и бетона и подвести к ним коммуникации.

Возвращаясь в Москву, я думал, почему у нас в России такого нет. Почему именно Чехия стала так популярна среди ИТ-компаний, которые не только открывают там новые офисы, но и переводят туда исправно работавшие центры из других стран. По соседству с DHL расположились Dell и Sony, по пути из Праги-1 в Чодов с трассы виден другой технопарк, в котором обустроилась Microsoft. Почему туда, а не к нам? Понятно, что Чехия удобнее расположена, если говорить о ведении бизнеса в Европе, но ведь у нас «такая база!», «такое образование!», «такие люди!». Спросите любого российского айтишника, и он расскажет, что американцы – идиоты, индийцы – совершенно не умеют писать код, а главное ИТ-достижение Чехии – штрих-код на бутылке «Старопрамен». Так почему же не к нам? Пусть не все, но хотя бы кто-то. Ведь мы тоже много говорим о технопарках и о том, как будет хорошо, если построить огромные здания из стекла и бетона и подвести к ним коммуникации. Развитие сервисов i-mode заставляет людей чаще менять мобильники. Сентябрьский опрос, проведенный среди 25 тысяч абонентов NTT DoCoMo, показал, что почти треть планирует поменять телефон в течение трех месяцев.

Развитие сервисов i-mode заставляет людей чаще менять мобильники. Сентябрьский опрос, проведенный среди 25 тысяч абонентов NTT DoCoMo, показал, что почти треть планирует поменять телефон в течение трех месяцев. Однако европейские производители мобильников не спешат выпускать модели, совместимые с модной платформой. «i-mode очень успешен у себя на родине, но темпы развития и уровень проникновения платформы в Европе далеки от японских, – говорит Гай Вейс, вице-президент компании Celltick Technologies, разработавшей технологию LiveScreen[В России известную под названием „Хамелеон“, о котором ниже]. – Производители мобильных телефонов обычно не спешат приспосабливать свои устройства к новым сервисам и делают это только в тех случаях, когда ROI[Return of investments, или возврат инвестиций] для них абсолютно очевиден». Меж тем еще два года назад NTT DoCoMo планировала набрать 10 млн. пользователей в странах за пределами Японии до 2010 года. Сейчас эти прогнозы обещают сбыться к концу текущего года, и, возможно, европейским брэндам придется стать менее консервативными[Так, компания Siemens планирует встраивать поддержку i-mode уже в телефоны Siemens CX70 и Siemens C75. Для этого достаточно заменить программное обеспечение аппаратов и, как следствие, пользовательский интерфейс].

Однако европейские производители мобильников не спешат выпускать модели, совместимые с модной платформой. «i-mode очень успешен у себя на родине, но темпы развития и уровень проникновения платформы в Европе далеки от японских, – говорит Гай Вейс, вице-президент компании Celltick Technologies, разработавшей технологию LiveScreen[В России известную под названием „Хамелеон“, о котором ниже]. – Производители мобильных телефонов обычно не спешат приспосабливать свои устройства к новым сервисам и делают это только в тех случаях, когда ROI[Return of investments, или возврат инвестиций] для них абсолютно очевиден». Меж тем еще два года назад NTT DoCoMo планировала набрать 10 млн. пользователей в странах за пределами Японии до 2010 года. Сейчас эти прогнозы обещают сбыться к концу текущего года, и, возможно, европейским брэндам придется стать менее консервативными[Так, компания Siemens планирует встраивать поддержку i-mode уже в телефоны Siemens CX70 и Siemens C75. Для этого достаточно заменить программное обеспечение аппаратов и, как следствие, пользовательский интерфейс]. Тем и хороша «Компьютерра», что умеет порадовать читателя эдакой изюминкой, неформатом. Чтобы не выглядеть на этом фоне брюзгой и критиканом, попробую лично подать пример конструктивного поведения и разыскать нечто такое, что возмутит женщин вопиющей бесполезностью в быту («да за такие-то деньжищи!»), а мужиков заставит подумать: «Нет, не понять вам, милые, высокого полета технической мысли… Эта вещь – просто услада для души, уставшей от рутины будней».

Тем и хороша «Компьютерра», что умеет порадовать читателя эдакой изюминкой, неформатом. Чтобы не выглядеть на этом фоне брюзгой и критиканом, попробую лично подать пример конструктивного поведения и разыскать нечто такое, что возмутит женщин вопиющей бесполезностью в быту («да за такие-то деньжищи!»), а мужиков заставит подумать: «Нет, не понять вам, милые, высокого полета технической мысли… Эта вещь – просто услада для души, уставшей от рутины будней». Боюсь, не все знают, в чем суть конструкции и назначение передатчика пропорциональной системы радиоуправления. Коротко поясню: угол механического отклонения двух рычажков управления (эдаких мини-джойстиков) преобразуется в пропорциональный двоичный код, которым модулируется радиосигнал. Радиоприемник модели принимает сигнал, декодер его расшифровывает и преобразует в импульсы управления сервомашинками. Те, в свою очередь, управляют механикой авиамодели. При построении такой системы можно вообще обойтись жесткой логикой. Но применение микроконтроллеров в передающем и приемном узлах заметно упрощает конструкцию.

Боюсь, не все знают, в чем суть конструкции и назначение передатчика пропорциональной системы радиоуправления. Коротко поясню: угол механического отклонения двух рычажков управления (эдаких мини-джойстиков) преобразуется в пропорциональный двоичный код, которым модулируется радиосигнал. Радиоприемник модели принимает сигнал, декодер его расшифровывает и преобразует в импульсы управления сервомашинками. Те, в свою очередь, управляют механикой авиамодели. При построении такой системы можно вообще обойтись жесткой логикой. Но применение микроконтроллеров в передающем и приемном узлах заметно упрощает конструкцию.|

|