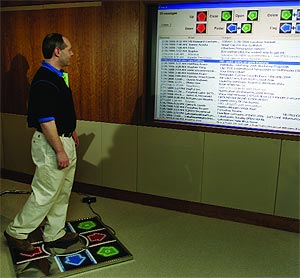

Ее авторы справедливо рассудили, что при работе за компьютером нагрузка на разные части тела распределяется неравномерно: если руки находятся в постоянном напряжении, то нижние конечности лишь покорно отбывают свой «срок» под столом. Учитывая, что избыточный вес и прочие неприятности, вызванные сидячим образом жизни, давно стали национальной проблемой в США, этот перекос неплохо было бы исправить. Нет ничего проще: разработчики Step UI взяли электронный мат, используемый для игры в Dance Dance Revolution (виртуальные пляски от Konami), и написали софт, учитывающий специфику альтернативного управления. Первыми программами, адаптированными под новые условия, стали почтовый клиент StepMail и электронный фотоальбом StepPhoto. Для работы с ними нужно наступать ногами на одну из шести зон коврика, отдавая тем самым желаемые команды. Например, чтобы открыть электронное письмо в StepMail, необходимо топнуть по расположенной в правом верхнем углу площадке. Думается, что в случае массового распространения технологии перед разработчиками остро встанет задача укрепления рабочей панели Step UI. Пользователи, получившие возможность буквально ногами давить мусорную корреспонденцию, запросто способны войти в раж и всю свою безмерную любовь к спамерам выместить на ни в чем неповинном электронном коврике.

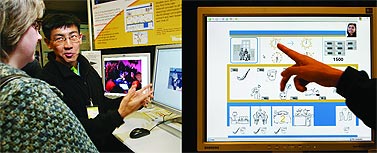

Ее авторы справедливо рассудили, что при работе за компьютером нагрузка на разные части тела распределяется неравномерно: если руки находятся в постоянном напряжении, то нижние конечности лишь покорно отбывают свой «срок» под столом. Учитывая, что избыточный вес и прочие неприятности, вызванные сидячим образом жизни, давно стали национальной проблемой в США, этот перекос неплохо было бы исправить. Нет ничего проще: разработчики Step UI взяли электронный мат, используемый для игры в Dance Dance Revolution (виртуальные пляски от Konami), и написали софт, учитывающий специфику альтернативного управления. Первыми программами, адаптированными под новые условия, стали почтовый клиент StepMail и электронный фотоальбом StepPhoto. Для работы с ними нужно наступать ногами на одну из шести зон коврика, отдавая тем самым желаемые команды. Например, чтобы открыть электронное письмо в StepMail, необходимо топнуть по расположенной в правом верхнем углу площадке. Думается, что в случае массового распространения технологии перед разработчиками остро встанет задача укрепления рабочей панели Step UI. Пользователи, получившие возможность буквально ногами давить мусорную корреспонденцию, запросто способны войти в раж и всю свою безмерную любовь к спамерам выместить на ни в чем неповинном электронном коврике. К подобным странам относится и густонаселенная Индия. Несмотря на многочисленные технопарки, возводимые здесь в последние годы, огромная часть населения даже не знает алфавита. Именно для таких людей одна из исследовательских лабораторий Microsoft, базирующаяся в Индии, разрабатывает ПО, позволяющее неграмотным людям получать доступ к необходимой информации. Поскольку, здешним жителям в большинстве своем не до развлечений, новинка в первую очередь нацелена на содействие в поиске работы. Софт полностью свободен от текста и общается с пользователем при помощи картинок, анимации и голосовых сообщений. Система была представлена на внутреннем смотре технологий Microsoft Research TechFest в числе других перспективных идей.

К подобным странам относится и густонаселенная Индия. Несмотря на многочисленные технопарки, возводимые здесь в последние годы, огромная часть населения даже не знает алфавита. Именно для таких людей одна из исследовательских лабораторий Microsoft, базирующаяся в Индии, разрабатывает ПО, позволяющее неграмотным людям получать доступ к необходимой информации. Поскольку, здешним жителям в большинстве своем не до развлечений, новинка в первую очередь нацелена на содействие в поиске работы. Софт полностью свободен от текста и общается с пользователем при помощи картинок, анимации и голосовых сообщений. Система была представлена на внутреннем смотре технологий Microsoft Research TechFest в числе других перспективных идей. Подавляющее большинство нынешних микрофонов, используемых в бытовых цифровых устройствах (динамические, конденсаторные), построены на основе традиционной аналоговой технологии. Новые цифровые версии микрофонов изготовляются на основе MEMS (микроэлектромеханических систем) с применением тех же литографических процессов, что свойственны производству микросхем, но с добавлением подвижных микроскопических деталей. Однако для этого требуются особые, специально подстроенные процессы производства, из-за чего MEMS-микрофоны до последнего времени получались слишком дорогими.

Подавляющее большинство нынешних микрофонов, используемых в бытовых цифровых устройствах (динамические, конденсаторные), построены на основе традиционной аналоговой технологии. Новые цифровые версии микрофонов изготовляются на основе MEMS (микроэлектромеханических систем) с применением тех же литографических процессов, что свойственны производству микросхем, но с добавлением подвижных микроскопических деталей. Однако для этого требуются особые, специально подстроенные процессы производства, из-за чего MEMS-микрофоны до последнего времени получались слишком дорогими. «Трехголовая» коробочка размером с компьютерную мышь вставляется в VGA-разъем видеокарты и распознается Windows как один-единственный дисплей разрешением до 3840x1024. Новое устройство использует принцип, заложенный в его предшественнике – выпущенном в ноябре прошлого года DualHead2Go, который управляется с двумя мониторами. Правда, в отличие от «старшего брата» нынешний гаджет куда более капризен в выборе аппаратуры: его поддержка «по зубам» лишь старшим моделям видеокарт ATI и nVidia.

«Трехголовая» коробочка размером с компьютерную мышь вставляется в VGA-разъем видеокарты и распознается Windows как один-единственный дисплей разрешением до 3840x1024. Новое устройство использует принцип, заложенный в его предшественнике – выпущенном в ноябре прошлого года DualHead2Go, который управляется с двумя мониторами. Правда, в отличие от «старшего брата» нынешний гаджет куда более капризен в выборе аппаратуры: его поддержка «по зубам» лишь старшим моделям видеокарт ATI и nVidia. Если в 1990-е годы, ввиду окончания холодной войны, одной из актуальнейших тем была конверсия, то есть адаптация и передача военных технологий на нужды мирного созидания, то теперь в публикациях научно-технической прессы все чаще можно найти рассказы о «конверсии наоборот». Иначе говоря, о том, как коммерческие или специальные сугубо мирные технологии с успехом внедряются для усиления борьбы с терроризмом и вообще с преступностью во всех ее проявлениях.

Если в 1990-е годы, ввиду окончания холодной войны, одной из актуальнейших тем была конверсия, то есть адаптация и передача военных технологий на нужды мирного созидания, то теперь в публикациях научно-технической прессы все чаще можно найти рассказы о «конверсии наоборот». Иначе говоря, о том, как коммерческие или специальные сугубо мирные технологии с успехом внедряются для усиления борьбы с терроризмом и вообще с преступностью во всех ее проявлениях. Идея полного контроля за мыслями и поступками человека или животных всегда представлялась чрезвычайно заманчивой людям с авторитарным складом ума. Исследования в этом направлении ведутся давно, и если применительно к опытам на людях этика еще более или менее срабатывает, то в отношении животных – вплоть до человекообразных обезьян – царит вседозволенность. Глубокая имплантация электродов в мозг шимпанзе или крыс считается обычным делом. Особенно когда речь идет о дистанционном управлении животным, да еще на щедрые деньги военных.

Идея полного контроля за мыслями и поступками человека или животных всегда представлялась чрезвычайно заманчивой людям с авторитарным складом ума. Исследования в этом направлении ведутся давно, и если применительно к опытам на людях этика еще более или менее срабатывает, то в отношении животных – вплоть до человекообразных обезьян – царит вседозволенность. Глубокая имплантация электродов в мозг шимпанзе или крыс считается обычным делом. Особенно когда речь идет о дистанционном управлении животным, да еще на щедрые деньги военных. Любопытное исследование провели социологи из Колумбийского университета в Нью-Йорке с помощью своего сайта musiclab.columbia.edu. Работа, впрочем, еще продолжается, и каждый может в ней поучаствовать. Исследование показало, как сильно мнение публики влияет на наш собственный вкус и как прихотлива судьба любого артиста.

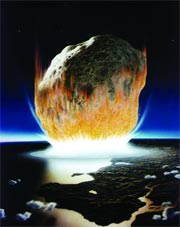

Любопытное исследование провели социологи из Колумбийского университета в Нью-Йорке с помощью своего сайта musiclab.columbia.edu. Работа, впрочем, еще продолжается, и каждый может в ней поучаствовать. Исследование показало, как сильно мнение публики влияет на наш собственный вкус и как прихотлива судьба любого артиста. Их полку прибыло. После наблюдений за астероидом 2004 VD17 выяснилось, что отныне ему суждено быть самым опасным на данный момент небесным телом для землян. Просчитав путь малой планеты на век вперед, ученые обнаружили, что вероятность столкновения астероида с Землей 4 мая 2102 года составляет примерно 0,00063. По математическим меркам вроде бы и немного, но вполне достаточно, чтобы еще раз задуматься о «внешней угрозе». И в самом деле, речь идет не о шансах поскользнуться на неухоженной улице, а о судьбе целой планеты, которая у каждого из нас одна и к тому же общая.

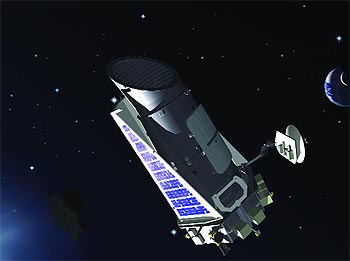

Их полку прибыло. После наблюдений за астероидом 2004 VD17 выяснилось, что отныне ему суждено быть самым опасным на данный момент небесным телом для землян. Просчитав путь малой планеты на век вперед, ученые обнаружили, что вероятность столкновения астероида с Землей 4 мая 2102 года составляет примерно 0,00063. По математическим меркам вроде бы и немного, но вполне достаточно, чтобы еще раз задуматься о «внешней угрозе». И в самом деле, речь идет не о шансах поскользнуться на неухоженной улице, а о судьбе целой планеты, которая у каждого из нас одна и к тому же общая. В 2001 году проект Dawn был выбран из 26 претендентов на участие в Discovery Program. В эту программу NASA планировалось включать недорогие разработки, нацеленные на запуск небольших космических аппаратов, как правило, для исследования нашей Солнечной системы. Пионером здесь был зонд NEAR, запущенный еще в 1996 году к астероиду Эрос. В конкурсном же отборе 2001 года, кроме Dawn, зеленый свет получил и проект Kepler. Этот аппарат (на рис.), вывод которого на орбиту вокруг Солнца намечен на 2008 год, должен целенаправленно искать планеты, похожие на Землю, возле других звезд. Должен, но… Погодок миссии Dawn, конечно, еще питает мечты о спасении, однако неофициальные слухи и о его скорой кончине все больше расползаются по Сети. Discovery Program – не самый важный приоритет для NASA в последние годы, и это, увы, тоже не открытие.

В 2001 году проект Dawn был выбран из 26 претендентов на участие в Discovery Program. В эту программу NASA планировалось включать недорогие разработки, нацеленные на запуск небольших космических аппаратов, как правило, для исследования нашей Солнечной системы. Пионером здесь был зонд NEAR, запущенный еще в 1996 году к астероиду Эрос. В конкурсном же отборе 2001 года, кроме Dawn, зеленый свет получил и проект Kepler. Этот аппарат (на рис.), вывод которого на орбиту вокруг Солнца намечен на 2008 год, должен целенаправленно искать планеты, похожие на Землю, возле других звезд. Должен, но… Погодок миссии Dawn, конечно, еще питает мечты о спасении, однако неофициальные слухи и о его скорой кончине все больше расползаются по Сети. Discovery Program – не самый важный приоритет для NASA в последние годы, и это, увы, тоже не открытие. С 1 апреля в Японии будет запрещена продажа через розничные сети примерно полутысячи наименований различных электронных устройств (телевизоров, аудиотехники и т. д.), произведенных до 2001 года. Новый закон, принятый после изменения процедур государственной сертификации, ставит под удар многих торговцев подержанной электроникой. Интересно, что перепродавать «неугодную» технику в частном порядке по-прежнему можно без ограничений. – Н.Я.

С 1 апреля в Японии будет запрещена продажа через розничные сети примерно полутысячи наименований различных электронных устройств (телевизоров, аудиотехники и т. д.), произведенных до 2001 года. Новый закон, принятый после изменения процедур государственной сертификации, ставит под удар многих торговцев подержанной электроникой. Интересно, что перепродавать «неугодную» технику в частном порядке по-прежнему можно без ограничений. – Н.Я. Существенной частью исследования был «эксперимент», когда ученые по согласованию с TSA, Администрацией безопасности полетов, садились на случайно выбранные авиарейсы, имея в ручной клади аппаратуру прослушивания – широкополосную антенну и анализатор электромагнитного спектра. Регистрация радиосигналов на борту показала, что при каждом коммерческом полете по сотовому телефону звонят в среднем от одного до четырех пассажиров. Чаще всего это происходит во время посадки самолета, когда, судя по всему, у людей кончается терпение.

Существенной частью исследования был «эксперимент», когда ученые по согласованию с TSA, Администрацией безопасности полетов, садились на случайно выбранные авиарейсы, имея в ручной клади аппаратуру прослушивания – широкополосную антенну и анализатор электромагнитного спектра. Регистрация радиосигналов на борту показала, что при каждом коммерческом полете по сотовому телефону звонят в среднем от одного до четырех пассажиров. Чаще всего это происходит во время посадки самолета, когда, судя по всему, у людей кончается терпение. Сведения об отсутствии в Ираке ОМП были получены в результате сверхсекретной операции, осуществленной по инициативе заместителя директора ЦРУ Чарльза Алена (Charles Allen). Он решил прибегнуть к помощи живущих в США родственников иракских специалистов, которых ЦРУ подозревало в причастности к программам создания ядерных, химических и биологических вооружений. По сведениям Райзена, в операции согласились участвовать около тридцати американцев иракского происхождения. Эти люди в 2002 году съездили в Ирак якобы по чисто семейным делам и задали своим родичам интересующие разведку вопросы. По возвращении все они доложили, что иракские программы создания ОМП были аннулированы вскоре после поражения Хусейна в Кувейте и с тех пор не возобновлялись. Чарльз Аллен был убежден, что эти отчеты адекватно отражают состояние иракского военного потенциала, и пытался убедить своих начальников. Однако высшие руководители ЦРУ отказались принять в расчет эти сведения и даже не сообщили о них Белому Дому. В результате достоверная информация об отсутствии оружия массового поражения у режима Саддама Хусейна надолго оказалась похороненной в архивах ЦРУ.

Сведения об отсутствии в Ираке ОМП были получены в результате сверхсекретной операции, осуществленной по инициативе заместителя директора ЦРУ Чарльза Алена (Charles Allen). Он решил прибегнуть к помощи живущих в США родственников иракских специалистов, которых ЦРУ подозревало в причастности к программам создания ядерных, химических и биологических вооружений. По сведениям Райзена, в операции согласились участвовать около тридцати американцев иракского происхождения. Эти люди в 2002 году съездили в Ирак якобы по чисто семейным делам и задали своим родичам интересующие разведку вопросы. По возвращении все они доложили, что иракские программы создания ОМП были аннулированы вскоре после поражения Хусейна в Кувейте и с тех пор не возобновлялись. Чарльз Аллен был убежден, что эти отчеты адекватно отражают состояние иракского военного потенциала, и пытался убедить своих начальников. Однако высшие руководители ЦРУ отказались принять в расчет эти сведения и даже не сообщили о них Белому Дому. В результате достоверная информация об отсутствии оружия массового поражения у режима Саддама Хусейна надолго оказалась похороненной в архивах ЦРУ. Бюджет зимней Олимпиады в Турине составил 707 млн. евро, из которых на техническую инфраструктуру было потрачено 257 млн. Кое-что выделило правительство Италии, но большая часть средств – 420 млн. – получена от спонсоров. Впрочем, не стоит думать, что организаторы страдали альтруизмом: по официальным данным, заработки от продажи прав на телетрансляции, входных билетов и лицензий на выпуск сувенирной продукции превысили 974 млн. евро, так что чистая выручка от праздника спорта – целых 268 млн.

Бюджет зимней Олимпиады в Турине составил 707 млн. евро, из которых на техническую инфраструктуру было потрачено 257 млн. Кое-что выделило правительство Италии, но большая часть средств – 420 млн. – получена от спонсоров. Впрочем, не стоит думать, что организаторы страдали альтруизмом: по официальным данным, заработки от продажи прав на телетрансляции, входных билетов и лицензий на выпуск сувенирной продукции превысили 974 млн. евро, так что чистая выручка от праздника спорта – целых 268 млн. Информационный центр Турина был готов к эксплуатации еще в начале октября прошлого года. За полсотни дней до зажжения олимпийского огня завершилось жесткое тестирование всех элементов центра в критических условиях – переизбытка данных, отказа коммуникационных каналов, сбоев в работе отдельных элементов, а общее время тестов превысило 100 тысяч часов[Разумеется, приводя эту цифру, организаторы не уточняют, что речь шла о суммарных временных затратах на каждый компонент системы, потому что иначе тесты пришлось бы начать одиннадцать лет назад. – С.В.].

Информационный центр Турина был готов к эксплуатации еще в начале октября прошлого года. За полсотни дней до зажжения олимпийского огня завершилось жесткое тестирование всех элементов центра в критических условиях – переизбытка данных, отказа коммуникационных каналов, сбоев в работе отдельных элементов, а общее время тестов превысило 100 тысяч часов[Разумеется, приводя эту цифру, организаторы не уточняют, что речь шла о суммарных временных затратах на каждый компонент системы, потому что иначе тесты пришлось бы начать одиннадцать лет назад. – С.В.]. Комплекс видеонаблюдения стал главным элементом Олимпийской системы безопасности, на которую было потрачено почти 90 млн. евро, а за его установку отвечала компания IndigoVision. Данные с шестисот камер Panasonic Super-Dynamic III в формате MPEG-4 с частотой 25 кадров в секунду передавались по IP-сетям в несколько центров безопасности и анализировались специальным программным обеспечением на наличие движения и нештатных ситуаций на олимпийских объектах.

Комплекс видеонаблюдения стал главным элементом Олимпийской системы безопасности, на которую было потрачено почти 90 млн. евро, а за его установку отвечала компания IndigoVision. Данные с шестисот камер Panasonic Super-Dynamic III в формате MPEG-4 с частотой 25 кадров в секунду передавались по IP-сетям в несколько центров безопасности и анализировались специальным программным обеспечением на наличие движения и нештатных ситуаций на олимпийских объектах. В ближайшее время МОК должен дать ответ на предложение Atos Origin о переводе софтверной инфраструктуры Олимпийских игр на Open Source. Впрочем, программный директор Atos Origin по Олимпийским играм 2006 в Турине Клод Филипс (Claude Philipps) уверен, что положительное решение будет принято еще до конца марта и программную платформу переведут на Open Source уже на пекинской Олимпиаде. По словам Филипса, это позволит не только сэкономить на лицензиях, но и сократить расходы, связанные с технической поддержкой, поскольку у Atos Origin в Китае нет деловых и технических партнеров, как в Европе.

В ближайшее время МОК должен дать ответ на предложение Atos Origin о переводе софтверной инфраструктуры Олимпийских игр на Open Source. Впрочем, программный директор Atos Origin по Олимпийским играм 2006 в Турине Клод Филипс (Claude Philipps) уверен, что положительное решение будет принято еще до конца марта и программную платформу переведут на Open Source уже на пекинской Олимпиаде. По словам Филипса, это позволит не только сэкономить на лицензиях, но и сократить расходы, связанные с технической поддержкой, поскольку у Atos Origin в Китае нет деловых и технических партнеров, как в Европе. Была разработана цифровая аппаратура с широким частотным и динамическим диапазонами для передачи вещательных сигналов. Кстати, это было первое в мировой практике использование цифрового вещательного оборудования. Повторюсь – на все про все ушло чуть больше двух лет. Помогла хорошая организация проекта: необходимое оборудование, вплоть до специальных стоек и мебели, поступало строго по графику и сразу же монтировалось. Вместе с тем нередко оборудование работало не так, как было нужно, и приходилось буквально на ходу находить причины и вносить изменения, добиваясь безупречной работы. Естественно, времени на такие доработки предусмотрено не было.

Была разработана цифровая аппаратура с широким частотным и динамическим диапазонами для передачи вещательных сигналов. Кстати, это было первое в мировой практике использование цифрового вещательного оборудования. Повторюсь – на все про все ушло чуть больше двух лет. Помогла хорошая организация проекта: необходимое оборудование, вплоть до специальных стоек и мебели, поступало строго по графику и сразу же монтировалось. Вместе с тем нередко оборудование работало не так, как было нужно, и приходилось буквально на ходу находить причины и вносить изменения, добиваясь безупречной работы. Естественно, времени на такие доработки предусмотрено не было. В модуле интернет-магазина обычно находятся средства для создания каталога товаров, корзины покупателя, оформления заказа и административного раздела. Общепринято наличие для каждой категории товаров страницы, содержащей краткие аннотации и предпросмотровые изображения для быстрой загрузки. Не стоит забывать и о том, что каждый элемент категории должен содержать гиперссылку для более детального знакомства с заинтересовавшим предметом, а встроенный в систему поиск по каталогу должен помочь клиенту быстро выйти на необходимую ему вещь. Для этого, помимо наименования и категории, должны использоваться другие критерии поиска – например, временной диапазон поступления, цена, страна-производитель и т. д. Ведь все мы понимаем: чем подробнее результаты поиска, тем выше шанс, что клиент не уйдет без покупки.

В модуле интернет-магазина обычно находятся средства для создания каталога товаров, корзины покупателя, оформления заказа и административного раздела. Общепринято наличие для каждой категории товаров страницы, содержащей краткие аннотации и предпросмотровые изображения для быстрой загрузки. Не стоит забывать и о том, что каждый элемент категории должен содержать гиперссылку для более детального знакомства с заинтересовавшим предметом, а встроенный в систему поиск по каталогу должен помочь клиенту быстро выйти на необходимую ему вещь. Для этого, помимо наименования и категории, должны использоваться другие критерии поиска – например, временной диапазон поступления, цена, страна-производитель и т. д. Ведь все мы понимаем: чем подробнее результаты поиска, тем выше шанс, что клиент не уйдет без покупки. Два слова о регистрации. Стандартная последовательность превращения посетителя в покупателя: «регистрация – выбор – покупка» может быть изменена. То есть, по желанию посетителя, он может зарегистрироваться до или после наполнения корзины. Данные, полученные в ходе авторизации, должны передаваться по SSL-протоколу или быть защищены другим эффективным способом. В момент обработки заказа необходимо показать покупателю уведомление о задержке в связи с приемом его данных – в противном случае, как показывает практика, покупатель может решить, что система просто «зависла», и прервать соединение. В общем, процесс покупки-продажи легко может сорваться на любом из этапов, поэтому помните – мелочей в е-бизнесе нет, и почаще вспоминайте заголовок книги Энди Гроувы «Выживают только параноики».

Два слова о регистрации. Стандартная последовательность превращения посетителя в покупателя: «регистрация – выбор – покупка» может быть изменена. То есть, по желанию посетителя, он может зарегистрироваться до или после наполнения корзины. Данные, полученные в ходе авторизации, должны передаваться по SSL-протоколу или быть защищены другим эффективным способом. В момент обработки заказа необходимо показать покупателю уведомление о задержке в связи с приемом его данных – в противном случае, как показывает практика, покупатель может решить, что система просто «зависла», и прервать соединение. В общем, процесс покупки-продажи легко может сорваться на любом из этапов, поэтому помните – мелочей в е-бизнесе нет, и почаще вспоминайте заголовок книги Энди Гроувы «Выживают только параноики».

Пользовательская часть системы отвечает за разграничение доступа к контенту для зарегистрированных пользователей с различным статусом. Регистрация состоит из двух этапов: заполнения соответствующей формы на публичной части сайта и подтверждения авторизации администратором. Думаю, многие сталкивались с этой процедурой при регистрации на форумах или открытии бесплатного аккаунта электронной почты: когда в базу данных заносится запись о новом пользователе, одно из полей записи имеет уникальный ключ, генерируемый на основе e-mail-адреса, который и отправляется в указанный посетителем ящик внутри URL. Перейдя по этому ключу, пользователь запускает обработчик, сравнивающий ключ в ссылке с записью в базе данных, и при совпадении обоих ключей регистрация завершается.

Пользовательская часть системы отвечает за разграничение доступа к контенту для зарегистрированных пользователей с различным статусом. Регистрация состоит из двух этапов: заполнения соответствующей формы на публичной части сайта и подтверждения авторизации администратором. Думаю, многие сталкивались с этой процедурой при регистрации на форумах или открытии бесплатного аккаунта электронной почты: когда в базу данных заносится запись о новом пользователе, одно из полей записи имеет уникальный ключ, генерируемый на основе e-mail-адреса, который и отправляется в указанный посетителем ящик внутри URL. Перейдя по этому ключу, пользователь запускает обработчик, сравнивающий ключ в ссылке с записью в базе данных, и при совпадении обоих ключей регистрация завершается. Другой отечественный разработчик ПО для интернет-магазинов – компания OSG – сделала ставку на тесную интеграцию с продукцией «1С». Несмотря на присутствие в линейке решений и CMS для сайтов некоммерческого профиля основные заказчики OSG – все же предприниматели, которым предлагается три варианта ПО в зависимости от масштаба бизнеса. В двух из них, Standard и Prof ($1000 и $4000 соответственно), используется ядро WebShop, позволяющее упростить управление магазином с учетной системой (прежде всего с «1С:Предприятием»).

Другой отечественный разработчик ПО для интернет-магазинов – компания OSG – сделала ставку на тесную интеграцию с продукцией «1С». Несмотря на присутствие в линейке решений и CMS для сайтов некоммерческого профиля основные заказчики OSG – все же предприниматели, которым предлагается три варианта ПО в зависимости от масштаба бизнеса. В двух из них, Standard и Prof ($1000 и $4000 соответственно), используется ядро WebShop, позволяющее упростить управление магазином с учетной системой (прежде всего с «1С:Предприятием»). А «OSG Интернет-магазин» получил сертификат качества от довольно авторитетного в круге рунетных веб-разработчиков портала SearchEngines.ru. Правда, в последнем случае сертифицировали не столько безопасность, сколько комфортность магазина для покупателя, что вполне вписывается в специфику сайта, посвященного преимущественно поисковой оптимизации и вопросам юзабилити. Так, было отмечено, что разработчикам из OSG удалось избежать стандартных ляпов, вроде перегрузки страницы html-элементами или некастомизированной страницы с сообщением об ошибке 404.

А «OSG Интернет-магазин» получил сертификат качества от довольно авторитетного в круге рунетных веб-разработчиков портала SearchEngines.ru. Правда, в последнем случае сертифицировали не столько безопасность, сколько комфортность магазина для покупателя, что вполне вписывается в специфику сайта, посвященного преимущественно поисковой оптимизации и вопросам юзабилити. Так, было отмечено, что разработчикам из OSG удалось избежать стандартных ляпов, вроде перегрузки страницы html-элементами или некастомизированной страницы с сообщением об ошибке 404. Как известно, квантовые компьютеры потенциально способны решать определенный круг задач гораздо быстрее, чем компьютеры классические. Скорость и эффективность поиска ответа достигаются за счет того, что квантовые биты можно помещать в состояние суперпозиции, когда кубит одновременно имеет значения логического нуля и единицы, и, «запутав» их состояния друг с другом, выполнять вычисления со всеми кубитами параллельно.

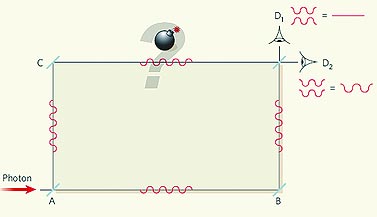

Как известно, квантовые компьютеры потенциально способны решать определенный круг задач гораздо быстрее, чем компьютеры классические. Скорость и эффективность поиска ответа достигаются за счет того, что квантовые биты можно помещать в состояние суперпозиции, когда кубит одновременно имеет значения логического нуля и единицы, и, «запутав» их состояния друг с другом, выполнять вычисления со всеми кубитами параллельно. Но у «квантового сапера» некоторый шанс есть. Для проверки наличия бомбы нужно взять простейший интерферометр Маха-Цендера (того самого Маха, философию которого критиковал в свое время Ленин). Интерферометр состоит из пары полупрозрачных (A и D) и пары обычных зеркал (B и С). Если его плечи одинаковы, то при отсутствии бомбы фотоны, запущенные слева в зеркало A, будет регистрировать только правый детектор D2, поскольку из-за интерференции волн света они полностью потушат друг друга и не попадут в верхний детектор D1. Причем такая интерференция наблюдается, даже если фотон лишь один, как это ни кажется парадоксальным.

Но у «квантового сапера» некоторый шанс есть. Для проверки наличия бомбы нужно взять простейший интерферометр Маха-Цендера (того самого Маха, философию которого критиковал в свое время Ленин). Интерферометр состоит из пары полупрозрачных (A и D) и пары обычных зеркал (B и С). Если его плечи одинаковы, то при отсутствии бомбы фотоны, запущенные слева в зеркало A, будет регистрировать только правый детектор D2, поскольку из-за интерференции волн света они полностью потушат друг друга и не попадут в верхний детектор D1. Причем такая интерференция наблюдается, даже если фотон лишь один, как это ни кажется парадоксальным. матрица: 1/1,8 дюйма, 8,1 Мп

матрица: 1/1,8 дюйма, 8,1 Мп оптическое разрешение: 1200x4800 dpi

оптическое разрешение: 1200x4800 dpi экран: 20 дюймов, MVA-матрица

экран: 20 дюймов, MVA-матрица фокусное расстояние: 27—88 мм (экв. 35 мм)

фокусное расстояние: 27—88 мм (экв. 35 мм) матрица: CCD 1/2,8 дюйма, 4,29 Мп

матрица: CCD 1/2,8 дюйма, 4,29 Мп Socket 775 для процессоров Intel Pentium 4, Pentium 4EE, Pentium D, Pentium XE и Celeron D

Socket 775 для процессоров Intel Pentium 4, Pentium 4EE, Pentium D, Pentium XE и Celeron D стандарты: GSM 900/1800/1900 МГц, UMTS 2100 МГц

стандарты: GSM 900/1800/1900 МГц, UMTS 2100 МГц матрица: 1/2,5 дюйма, 7,2 Мп

матрица: 1/2,5 дюйма, 7,2 Мп стандарт: GSM 850/900/1800/1900 МГц

стандарт: GSM 850/900/1800/1900 МГц стандарты: GSM 900/1800/ 1900 МГц, UMTS 2100 МГц

стандарты: GSM 900/1800/ 1900 МГц, UMTS 2100 МГц матрица: 1/1,8 дюйма, 6,1 Мп

матрица: 1/1,8 дюйма, 6,1 Мп процессор: Intel Celeron M 370 1,50 ГГц, FSB 400 МГц

процессор: Intel Celeron M 370 1,50 ГГц, FSB 400 МГц дисплей: CSTN, 1,5 дюйма, 128x128, 4096 цветов

дисплей: CSTN, 1,5 дюйма, 128x128, 4096 цветов процессор: Mobile AMD Turion 64 MT-xx или Mobile AMD Sempron 3000+…3400+

процессор: Mobile AMD Turion 64 MT-xx или Mobile AMD Sempron 3000+…3400+ встроенная память: 8 Гбайт

встроенная память: 8 Гбайт процессор семейства Intel Core Duo

процессор семейства Intel Core Duo

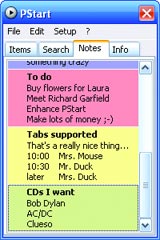

Правда, большинство программ болезненно воспринимают перенос в новую среду и без переустановки могут попросту не заработать. Они хранят свои настройки в системном реестре, используют системные же dll-файлы, а некоторые особенно мнительные представители софтверной фауны могут посчитать попытку запуска на другом компьютере злостным нарушением лицензии – со всеми вытекающими последствиями. Оставлять свои логины-пароли на чужом компьютере тоже не всегда хочется.

Правда, большинство программ болезненно воспринимают перенос в новую среду и без переустановки могут попросту не заработать. Они хранят свои настройки в системном реестре, используют системные же dll-файлы, а некоторые особенно мнительные представители софтверной фауны могут посчитать попытку запуска на другом компьютере злостным нарушением лицензии – со всеми вытекающими последствиями. Оставлять свои логины-пароли на чужом компьютере тоже не всегда хочется.

При всех своих достоинствах Knoppix обладает одним существенным недостатком: все компоненты операционной системы записаны на оптический носитель, что не позволяет вносить изменения в системные или конфигурационные файлы. Точнее, во время работы в Knoppix изменять можно что угодно – от настроек темы рабочего стола до характеристик аппаратной части компьютера, но при следующей загрузке все придется восстанавливать заново. Для исправления этого досадного казуса предусмотрена специальная команда меню, позволяющая сохранять изменения на флэш-накопитель. При следующем старте Knoppix достаточно указать соответствующий параметр загрузки, указывающий операционной системе место размещения пользовательских настроек, и ваша операционная система обретет свою индивидуальность согласно вашим предпочтениям.

При всех своих достоинствах Knoppix обладает одним существенным недостатком: все компоненты операционной системы записаны на оптический носитель, что не позволяет вносить изменения в системные или конфигурационные файлы. Точнее, во время работы в Knoppix изменять можно что угодно – от настроек темы рабочего стола до характеристик аппаратной части компьютера, но при следующей загрузке все придется восстанавливать заново. Для исправления этого досадного казуса предусмотрена специальная команда меню, позволяющая сохранять изменения на флэш-накопитель. При следующем старте Knoppix достаточно указать соответствующий параметр загрузки, указывающий операционной системе место размещения пользовательских настроек, и ваша операционная система обретет свою индивидуальность согласно вашим предпочтениям.

Не стоит забывать и про норвежскую «Оперу». Несмотря на то что разработчики не предоставляют официальной portable-версии, по ключевым словам «Opera USB» можно найти множество подробных инструкций и неофициальных «сборок», позволяющих исправить этот недостаток. В результате мы сразу получим в очень маленьком дистрибутиве не только отличный браузер, но еще и почтовый клиент, RSS-читалку и клиент IRC! И все это без потери куков, кэша и т. д. и всего лишь в виде десяти мегабайт после установки.

Не стоит забывать и про норвежскую «Оперу». Несмотря на то что разработчики не предоставляют официальной portable-версии, по ключевым словам «Opera USB» можно найти множество подробных инструкций и неофициальных «сборок», позволяющих исправить этот недостаток. В результате мы сразу получим в очень маленьком дистрибутиве не только отличный браузер, но еще и почтовый клиент, RSS-читалку и клиент IRC! И все это без потери куков, кэша и т. д. и всего лишь в виде десяти мегабайт после установки. Что касается самой программы, то это совершенно самостоятельный и практически полноценный клиент The Bat, запускаемый с флэшки. Существенные отличия – обязательное использование пароля для запуска программы и шифрование базы на лету. Поскольку база зашифрована, то, естественно, простым копированием папок с большого компьютера на флэш-драйв синхронизировать установленный на хосте мейлер (он, кстати, может быть зарегистрирован с другим ключом) с Voyager не удастся. Для этого нужно использовать собственные средства The Bat для выгрузки и загрузки базы сообщений (в программе почему-то загрузка и выгрузка объединены в трехшаговый процесс – эдакая причуда юзабилити, – но работает все на ура). Таким образом, если вы потеряли флэшку, то ее новый обладатель не получит доступа к вашей почте (мастер-пароль); если кто-нибудь излишне любопытный перепишет содержимое флэшки на свой диск, то доступа к вашей базе он опять-таки не получит (при установке Voyager на новый драйв программу нужно перерегистрировать, она «привязана» к диску). Собственно, пользователь должен заботиться только о регулярности бэкапов.

Что касается самой программы, то это совершенно самостоятельный и практически полноценный клиент The Bat, запускаемый с флэшки. Существенные отличия – обязательное использование пароля для запуска программы и шифрование базы на лету. Поскольку база зашифрована, то, естественно, простым копированием папок с большого компьютера на флэш-драйв синхронизировать установленный на хосте мейлер (он, кстати, может быть зарегистрирован с другим ключом) с Voyager не удастся. Для этого нужно использовать собственные средства The Bat для выгрузки и загрузки базы сообщений (в программе почему-то загрузка и выгрузка объединены в трехшаговый процесс – эдакая причуда юзабилити, – но работает все на ура). Таким образом, если вы потеряли флэшку, то ее новый обладатель не получит доступа к вашей почте (мастер-пароль); если кто-нибудь излишне любопытный перепишет содержимое флэшки на свой диск, то доступа к вашей базе он опять-таки не получит (при установке Voyager на новый драйв программу нужно перерегистрировать, она «привязана» к диску). Собственно, пользователь должен заботиться только о регулярности бэкапов. Надо полагать, что именно этот дефект – из всего букета – проще всего поддавался какому-никакому исправлению, поскольку и новейшие TN+film-панели не дают черного и меняют цвета и яркости, даже когда сидишь прямо перед монитором: константы не удалось добиться просто на площади самого монитора, и верхушка панели отличается от центра или низа, когда вызываешь на экран ровно-серую заливку, – попытка же довести передаваемый цвет до TrueColor’а делается исключительно программным путем: цвет по-прежнему передается 18-битный (262 тысячи оттенков), а те цвета, которые в эту палитру не попадают, должны возникать не на мониторе, а в нашем мозгу – за счет частого мигания соседних, доступных (технология Frame Rate Control). Правда, чтобы соседние и впрямь мигали достаточно часто, время отклика должно быть по-настоящему маленьким, – на деле же я пока не встретил ни одного TN+film-монитора (и описываемый – не исключение), где не были бы заметны цветовые границы на градиентных заливках. Правду сказать, хоть обычно производители предпочитают умалчивать о программном увеличении числа различаемых цветов, самые совестливые (и BenQ среди них) помечают на своих мониторах не полные 16,7 млн. оттенков TrueColor’а, а неизвестно откуда взявшиеся – вероятно, из математики FRC – 16,2 млн.

Надо полагать, что именно этот дефект – из всего букета – проще всего поддавался какому-никакому исправлению, поскольку и новейшие TN+film-панели не дают черного и меняют цвета и яркости, даже когда сидишь прямо перед монитором: константы не удалось добиться просто на площади самого монитора, и верхушка панели отличается от центра или низа, когда вызываешь на экран ровно-серую заливку, – попытка же довести передаваемый цвет до TrueColor’а делается исключительно программным путем: цвет по-прежнему передается 18-битный (262 тысячи оттенков), а те цвета, которые в эту палитру не попадают, должны возникать не на мониторе, а в нашем мозгу – за счет частого мигания соседних, доступных (технология Frame Rate Control). Правда, чтобы соседние и впрямь мигали достаточно часто, время отклика должно быть по-настоящему маленьким, – на деле же я пока не встретил ни одного TN+film-монитора (и описываемый – не исключение), где не были бы заметны цветовые границы на градиентных заливках. Правду сказать, хоть обычно производители предпочитают умалчивать о программном увеличении числа различаемых цветов, самые совестливые (и BenQ среди них) помечают на своих мониторах не полные 16,7 млн. оттенков TrueColor’а, а неизвестно откуда взявшиеся – вероятно, из математики FRC – 16,2 млн.

После его ухода я принялся гонять по экрану тестовые пляшущие квадраты и бегающую трехцветную палку: да, в таком сугубо тестовом, далеким от реальной жизни режиме я все равно обнаружил на передней и задней стенках белого на черном квадрата некоторое… замыливание. Ну и что с того?

После его ухода я принялся гонять по экрану тестовые пляшущие квадраты и бегающую трехцветную палку: да, в таком сугубо тестовом, далеким от реальной жизни режиме я все равно обнаружил на передней и задней стенках белого на черном квадрата некоторое… замыливание. Ну и что с того? Перечитывая список возможностей альтернативной операционной системы, я уже плакал:

Перечитывая список возможностей альтернативной операционной системы, я уже плакал: – Весь документооборот осуществлялся на бумаге, и действовала специальная фельдъегерская служба, развозившая по стране платежные документы. Служба обходилась очень недешево. Точную цифру я назвать не могу, но она была весьма и весьма ощутима, учитывая, что объектов Казначейства в России более двух тысяч, а количество бюджетополучателей и распорядителей превышает четыреста тысяч. Даже если каждому из них написать по одному письму и отправить такой службой, представляете, сколько потребуется бумаги…

– Весь документооборот осуществлялся на бумаге, и действовала специальная фельдъегерская служба, развозившая по стране платежные документы. Служба обходилась очень недешево. Точную цифру я назвать не могу, но она была весьма и весьма ощутима, учитывая, что объектов Казначейства в России более двух тысяч, а количество бюджетополучателей и распорядителей превышает четыреста тысяч. Даже если каждому из них написать по одному письму и отправить такой службой, представляете, сколько потребуется бумаги… Начнем с магнитострикционного эффекта, обнаруженного в ферромагнитных материалах (например, в железе, никеле и др.) еще в 1842 г. Суть эффекта магнитострикции показана на рис. 2 и заключена в следующем: если поместить образец в магнитное поле, его форма и размеры изменятся. Это изменение было очень незначительным и в среднем составляло всего 0,003 %. Однако в 1961 г. у редкоземельных металлов тербия Tb, диспрозия Dy и некоторых их сплавов был открыт эффект гигантской магнитострикции, величина которого больше на два порядка: 0,5 % для сплава TbDyZn. Это позволило создать высокочувствительные магнитострикционные механизмы микроперемещений и нажимных устройств, принципиально новые генераторы мощного звука и ультразвука, сверхчувствительные приемники звука. Были улучшены характеристики линий задержки звуковых и электрических сигналов, а также других устройств для радиотехники и электросвязи.

Начнем с магнитострикционного эффекта, обнаруженного в ферромагнитных материалах (например, в железе, никеле и др.) еще в 1842 г. Суть эффекта магнитострикции показана на рис. 2 и заключена в следующем: если поместить образец в магнитное поле, его форма и размеры изменятся. Это изменение было очень незначительным и в среднем составляло всего 0,003 %. Однако в 1961 г. у редкоземельных металлов тербия Tb, диспрозия Dy и некоторых их сплавов был открыт эффект гигантской магнитострикции, величина которого больше на два порядка: 0,5 % для сплава TbDyZn. Это позволило создать высокочувствительные магнитострикционные механизмы микроперемещений и нажимных устройств, принципиально новые генераторы мощного звука и ультразвука, сверхчувствительные приемники звука. Были улучшены характеристики линий задержки звуковых и электрических сигналов, а также других устройств для радиотехники и электросвязи. Широко известный пьезоэлектрический эффект был открыт в 1880 г. и с тех пор нашел применение как в промышленности, так и быту (его используют, например, в пьезозажигалках). Пьезоэлементы созданы из материалов, при деформации которых появляется электрический потенциал. На рис. 3. показано возникновение потенциала при деформации кристалла кварца. Если же мы поместим их в электрическое поле, то пьезоэлементы деформируются – это инверсионный пьезоэлектрический эффект. Материалы, которые используют в качестве пьезоэлементов, можно разбить на две группы: пьезоэлектрические монокристаллы и пьезокерамика. Максимальная величина классического пьезоэлектрического эффекта получена для керамики и составляет около 0,17 %. Гигантский пьезоэлектрический эффект, равный 1,7 %, достигнут в пьезокерамике PMN-PT (свинец, магний, ниобат/свинцовый титанат). Такие пьезоэлементы нашли применение в промышленности в качестве датчиков различных физических величин (ускорения, давления, изменения размеров), пьезоприводов механизмов и т. д. Массив из микрозеркал, в основе которого лежат пьезоэлементы, позволяет создать управляющие устройства для волоконно-оптических сетей. В последние годы наблюдается стремительный прогресс в разработке нано– и микроэлектромеханических устройств, способных передвигаться, собирать, хранить и передавать информацию, осуществлять определенные воздействия по заложенной программе или команде. Разработку микроприводов, а также пьезоэлектрических генераторов невозможно представить без материалов с гигантским пьезоэффектом.

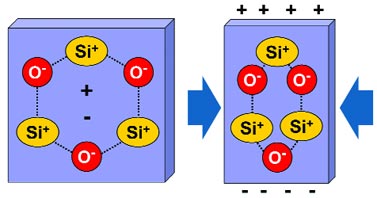

Широко известный пьезоэлектрический эффект был открыт в 1880 г. и с тех пор нашел применение как в промышленности, так и быту (его используют, например, в пьезозажигалках). Пьезоэлементы созданы из материалов, при деформации которых появляется электрический потенциал. На рис. 3. показано возникновение потенциала при деформации кристалла кварца. Если же мы поместим их в электрическое поле, то пьезоэлементы деформируются – это инверсионный пьезоэлектрический эффект. Материалы, которые используют в качестве пьезоэлементов, можно разбить на две группы: пьезоэлектрические монокристаллы и пьезокерамика. Максимальная величина классического пьезоэлектрического эффекта получена для керамики и составляет около 0,17 %. Гигантский пьезоэлектрический эффект, равный 1,7 %, достигнут в пьезокерамике PMN-PT (свинец, магний, ниобат/свинцовый титанат). Такие пьезоэлементы нашли применение в промышленности в качестве датчиков различных физических величин (ускорения, давления, изменения размеров), пьезоприводов механизмов и т. д. Массив из микрозеркал, в основе которого лежат пьезоэлементы, позволяет создать управляющие устройства для волоконно-оптических сетей. В последние годы наблюдается стремительный прогресс в разработке нано– и микроэлектромеханических устройств, способных передвигаться, собирать, хранить и передавать информацию, осуществлять определенные воздействия по заложенной программе или команде. Разработку микроприводов, а также пьезоэлектрических генераторов невозможно представить без материалов с гигантским пьезоэффектом. Еще один гигантский эффект, результат внедрения которого почувствовал каждый пользователь компьютера, – эффект гигантского магнитосопротивления. Читатели, наверное, помнят, что в конце 90-х годов средняя емкость жесткого диска составляла примерно 20 Гбайт, что соответствовало плотности записи информации около 4,1 Гбайт/кв. дюйм. Однако сегодня емкость жестких дисков возросла до 400 Гбайт, а плотность записи достигла 100 Гбайт/кв. дюйм. С чем связан такой стремительный рост?

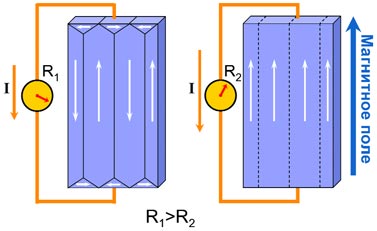

Еще один гигантский эффект, результат внедрения которого почувствовал каждый пользователь компьютера, – эффект гигантского магнитосопротивления. Читатели, наверное, помнят, что в конце 90-х годов средняя емкость жесткого диска составляла примерно 20 Гбайт, что соответствовало плотности записи информации около 4,1 Гбайт/кв. дюйм. Однако сегодня емкость жестких дисков возросла до 400 Гбайт, а плотность записи достигла 100 Гбайт/кв. дюйм. С чем связан такой стремительный рост? Удельное электросопротивление магнитных материалов зависит от угла между магнитным полем и током. Это явление назвали анизотропным магнитосопротивлением. Несмотря на небольшую величину этого эффекта он широко используется в приборах для измерения магнитных, электрических, механических и других физических величин, системах автоматизации и сигнализации, в средствах хранения информации. Однако сегодня наибольший интерес вызывают материалы с эффектом гигантского магнитосопротивления. В следующем разделе мы расскажем о нем более детально.

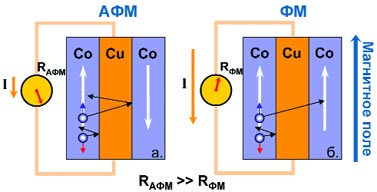

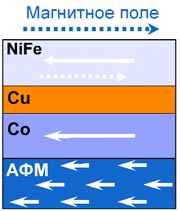

Удельное электросопротивление магнитных материалов зависит от угла между магнитным полем и током. Это явление назвали анизотропным магнитосопротивлением. Несмотря на небольшую величину этого эффекта он широко используется в приборах для измерения магнитных, электрических, механических и других физических величин, системах автоматизации и сигнализации, в средствах хранения информации. Однако сегодня наибольший интерес вызывают материалы с эффектом гигантского магнитосопротивления. В следующем разделе мы расскажем о нем более детально. В ферромагнитных материалах выделяют два типа электронов в зависимости от ориентации их спина: «спин-вверх» и «спин-вниз». На рисунке направление спина обозначено синими и красными стрелками. Оказалось, что если ориентация спина не совпадает с магнитным моментом слоя (АФМ-конфигурация), то электрон не может попасть в этот слой, и электросопротивление становится больше. После перехода конфигурации из антиферромагнитной в ферромагнитную при возрастании внешнего магнитного поля электрон способен перескочить в смежный слой, и сопротивление значительно уменьшается. Этот эффект и называется гигантским магнитосопротивлением (ГМС).

В ферромагнитных материалах выделяют два типа электронов в зависимости от ориентации их спина: «спин-вверх» и «спин-вниз». На рисунке направление спина обозначено синими и красными стрелками. Оказалось, что если ориентация спина не совпадает с магнитным моментом слоя (АФМ-конфигурация), то электрон не может попасть в этот слой, и электросопротивление становится больше. После перехода конфигурации из антиферромагнитной в ферромагнитную при возрастании внешнего магнитного поля электрон способен перескочить в смежный слой, и сопротивление значительно уменьшается. Этот эффект и называется гигантским магнитосопротивлением (ГМС). Варьируя материал, толщину и последовательность слоев, можно оптимизировать магнитные и электрические свойства таких наноструктур и расширить область их практического применения. За несколько лет, прошедших с момента открытия спиновых вентилей, было создано и исследовано не менее одиннадцати их видов с различной структурой.

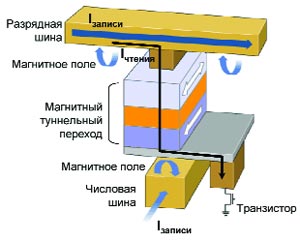

Варьируя материал, толщину и последовательность слоев, можно оптимизировать магнитные и электрические свойства таких наноструктур и расширить область их практического применения. За несколько лет, прошедших с момента открытия спиновых вентилей, было создано и исследовано не менее одиннадцати их видов с различной структурой. Сегодня разработку MRAM-памяти ведут несколько фирм: Motorola, IBM, Infineon, Cypress Semiconductor, TSMC, а также совместно NEC и Toshiba. Большинство из них остановились на MRAM-памяти с магнитным туннельным переходом. Схема ячейки памяти, в которой перемагничивание осуществляется по методу Савченко, разработанному в компании Motorola, представлена на рис. 7. Ячейка памяти сформирована на пересечении разрядной и числовой шин. Она состоит из структуры с магнитным туннельным переходом, которая отвечает за хранение информации, и транзистора, с помощью которого организована адресация. Существуют схемы, в которых транзистор заменен диодом или вообще отсутствует. Ток, протекающий по разрядной и числовой шинам, наводит перекрестное магнитное поле, которое изменяет магнитное состояние свободного слоя. При считывании измеряется ток, протекающий через ячейку. Его величина зависит от конфигурации намагниченности магнитных слоев структуры: при параллельной ориентации сопротивление перехода минимально. Это соответствует логическому "0". При антипараллельной ориентации намагниченностей сопротивление велико, туннельный ток мал – это логическая "1".

Сегодня разработку MRAM-памяти ведут несколько фирм: Motorola, IBM, Infineon, Cypress Semiconductor, TSMC, а также совместно NEC и Toshiba. Большинство из них остановились на MRAM-памяти с магнитным туннельным переходом. Схема ячейки памяти, в которой перемагничивание осуществляется по методу Савченко, разработанному в компании Motorola, представлена на рис. 7. Ячейка памяти сформирована на пересечении разрядной и числовой шин. Она состоит из структуры с магнитным туннельным переходом, которая отвечает за хранение информации, и транзистора, с помощью которого организована адресация. Существуют схемы, в которых транзистор заменен диодом или вообще отсутствует. Ток, протекающий по разрядной и числовой шинам, наводит перекрестное магнитное поле, которое изменяет магнитное состояние свободного слоя. При считывании измеряется ток, протекающий через ячейку. Его величина зависит от конфигурации намагниченности магнитных слоев структуры: при параллельной ориентации сопротивление перехода минимально. Это соответствует логическому "0". При антипараллельной ориентации намагниченностей сопротивление велико, туннельный ток мал – это логическая "1". Краткая биографическая справка рисует нам человека целеустремленного, волевого и довольно жесткого: Джимми заработал капитал на торговле фьючерсами, организовал работавшую с adult content сеть Bornis, создал на пару с Ларри Сэнгером Википедию, сумев эффективно организовать работу десятков, а то и сотен тысяч человек… На самом деле, Уэйлс – приветливый, тихий и очень-очень уставший.

Краткая биографическая справка рисует нам человека целеустремленного, волевого и довольно жесткого: Джимми заработал капитал на торговле фьючерсами, организовал работавшую с adult content сеть Bornis, создал на пару с Ларри Сэнгером Википедию, сумев эффективно организовать работу десятков, а то и сотен тысяч человек… На самом деле, Уэйлс – приветливый, тихий и очень-очень уставший.

<%=p.Content%>

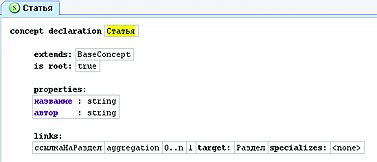

Следующий этап проектирования состоит в том, чтобы внести разработанную нами модель данных в языковой инструментарий. При этом для каждого понятия предметной области необходимо создать соответствующую концепцию языка. Например, концепция «статья» выглядит в MPS так, как изображено на рис. 2. На этом проектирование нашего языка можно считать завершенным.

Следующий этап проектирования состоит в том, чтобы внести разработанную нами модель данных в языковой инструментарий. При этом для каждого понятия предметной области необходимо создать соответствующую концепцию языка. Например, концепция «статья» выглядит в MPS так, как изображено на рис. 2. На этом проектирование нашего языка можно считать завершенным. Кто-нибудь может возразить: язык – это в первую очередь знаковая система, а то, что мы только что создали, является скорее некоторой объектной моделью. Действительно, мы разработали только часть языка, традиционно называемую абстрактным синтаксисом. Если так можно выразиться, «знаковой системой» DSL в контексте языковых инструментариев являются редакторы, обеспечивающие визуальное отображение понятий языка.

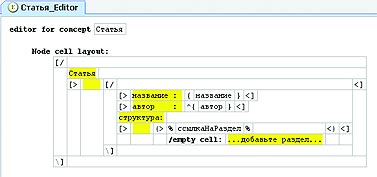

Кто-нибудь может возразить: язык – это в первую очередь знаковая система, а то, что мы только что создали, является скорее некоторой объектной моделью. Действительно, мы разработали только часть языка, традиционно называемую абстрактным синтаксисом. Если так можно выразиться, «знаковой системой» DSL в контексте языковых инструментариев являются редакторы, обеспечивающие визуальное отображение понятий языка. MPS обладает встроенным дизайнером для создания редакторов DSL, основанном на идее вложенных ячеек. Поясним эту идею на примере редактора для концепции «статья». На рис. 3 ячейка-контейнер верхнего уровня содержит две дочерние ячейки, расположенные вертикально. Верхняя ячейка содержит константное слово «статья», а нижняя является горизонтальным контейнером для других ячеек. И так далее.

MPS обладает встроенным дизайнером для создания редакторов DSL, основанном на идее вложенных ячеек. Поясним эту идею на примере редактора для концепции «статья». На рис. 3 ячейка-контейнер верхнего уровня содержит две дочерние ячейки, расположенные вертикально. Верхняя ячейка содержит константное слово «статья», а нижняя является горизонтальным контейнером для других ячеек. И так далее. После определения «раскладки» составных частей остается связать с редактором атрибуты «название» и «автор», дополнить его возможностью выбора автора из списка, и получится нечто, изображенное на рис. 4. Процесс редактирования документов при помощи такого редактора очень прост и вполне удобен (хотя и слегка непривычен). Например, для добавления подраздела необходимо перейти в ячейку «…добавьте подраздел…» и начать ввод текста. После нажатия клавиши Enter фокус ввода переместится на следующий подраздел.

После определения «раскладки» составных частей остается связать с редактором атрибуты «название» и «автор», дополнить его возможностью выбора автора из списка, и получится нечто, изображенное на рис. 4. Процесс редактирования документов при помощи такого редактора очень прост и вполне удобен (хотя и слегка непривычен). Например, для добавления подраздела необходимо перейти в ячейку «…добавьте подраздел…» и начать ввод текста. После нажатия клавиши Enter фокус ввода переместится на следующий подраздел. Возможно, многим покажется, что вышеописанный подход к разработке – не более чем преодоление трудностей, которые мы сами же себе и создали, приняв решение вести проект системы на DSL, однако список полученных при этом преимуществ весьма внушителен:

Возможно, многим покажется, что вышеописанный подход к разработке – не более чем преодоление трудностей, которые мы сами же себе и создали, приняв решение вести проект системы на DSL, однако список полученных при этом преимуществ весьма внушителен:|

|